Diferența dintre Hadoop și SQL

Datele enorme generate în fiecare secundă prin intermediul Social Media precum Facebook, Twitter, Instagram au deschis calea pentru dezvoltarea Hadoop / Big Data Ecosystem. Termenul „3V” referindu-se la volum, viteză și veracitate definește importanța Hadoop pentru a gestiona fluxul de date. Astăzi, datele sunt generate din mai multe surse, care sunt necesare pentru a fi integrate în diverse scopuri, cum ar fi Raportarea, Analiza datelor și Cercetarea și pentru stocarea centralizată a datelor. Când facem acest lucru, apar numeroase probleme cu abordări tradiționale precum spațiul, accesul, integritatea, structura și lățimea de bandă. Pentru a rezolva toate aceste probleme, Hadoop oferă un cadru care permite procesarea datelor cu dimensiuni uriașe, pentru a oferi acces facil, disponibilitate ridicată și pentru a încărca datele în mod dinamic. Are un cadru de sistem de fișiere distribuit (HDFS) pentru stocarea datelor și procesorului de interogare integrat numit „Map Reduce” pentru analiza și procesarea datelor stocate în HDFS.

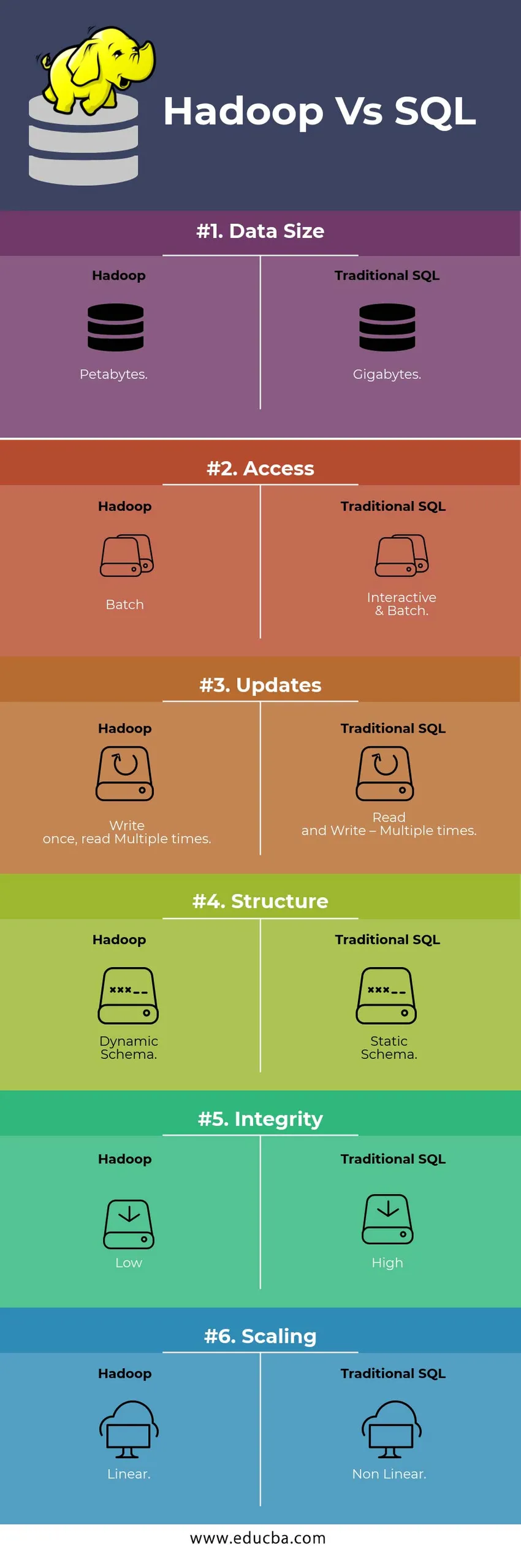

Comparatie HEAD TO HEAD Comparatie intre Hadoop Vs SQL

Mai jos este principala 6 diferență între Hadoop Vs SQL

Diferențele cheie între Hadoop Vs SQL

Mai jos este diferența dintre Hadoop și SQL sunt următoarele

- Schema pe WRITE Vs CITESTE

În general, într-o bază de date tradițională, în timpul încărcării / migrației de date de la o bază de date la alta, urmează schema abordării de scriere. Acest lucru face ca procesul de încărcare a datelor să fie excitat / avortat și are ca rezultat respingerea înregistrărilor, datorită unei diferențe în structura sursei și a tabelelor țintă, întrucât în sistemul Hadoop, toate datele sunt stocate în HDFS și datele sunt centralizate.

Cadrul Hadoop este utilizat în principal pentru procesul de date Analytics. Astfel, acceptă toate cele trei categorii de date, adică date structurate, semi-structurate și nestructurate și permite abordarea schemei de citire.

- Datele structurate au un format definit. g .: fișier XML.

- Datele Semi Structures sunt mai slabe; Poate / nu are o schemă. g .: foaie de calcul

- Datele nestructurate nu au o structură specifică sau o schemă. De exemplu: text simplu sau imagine.

Hadoop funcționează eficient cu date nestructurate, deoarece are capacitatea de a interpreta datele în timpul procesării.

| Abordare | Avantaj | Dezavantaj |

| Schema pe scriere | · Structuri predefinite

· Citește mai repede. De exemplu: RDBMS tradițional. | Încărcare lentă a datelor

Latenție ridicată |

| Schema de citire | · Structura dinamică

· Scrieți și citiți rapid. De exemplu: Hadoop | Încărcare rapidă de date

Latenta scazuta |

Tabel : Schemă pe WRITE VS Schema pe CITEȘTE.

- SCALABILITATE & COST

Hadoop Framework este proiectat pentru a prelucra un volum mare de date. Ori de câte ori mărimea datelor crește, un număr de resurse suplimentare precum nodul de date pot fi adăugate în cluster foarte ușor decât abordarea tradițională a alocării statice a memoriei. Timpul și bugetul sunt relativ foarte puțin pentru implementarea lor și, de asemenea, Hadoop oferă Locația datelor unde datele sunt disponibile în nodul care a executat lucrarea.

- TOLERANȚĂ FAILĂ

În RDBMS tradițional, atunci când datele sunt pierdute din cauza corupției sau a oricărei probleme de rețea, este nevoie de mai mult timp, cost și resurse pentru a recupera datele pierdute. Dar, Hadoop are un mecanism în care datele au cel puțin trei niveluri de factor de replicare pentru datele care sunt stocate în HDFS. Dacă unul dintre nodurile de date care conțin date este eșuat, datele pot fi trase ușor din alte noduri de date cu o mare disponibilitate a datelor. Prin urmare, face ca datele să fie ușor accesibile pentru utilizator indiferent de eșec.

- PROGRAMARE FUNCȚIONALĂ

Hadoop acceptă scrierea programării funcționale în limbi precum java, scala și python. Pentru orice aplicație care necesită orice funcționalitate suplimentară poate fi implementată prin înregistrarea UDF - Funcțiile definite de utilizator în HDFS. În RDBMS, nu există posibilitatea de a scrie UDF și aceasta crește complexitatea scrierii SQL. Mai mult, datele stocate în HDFS pot fi accesate de toate ecosistemele Hadoop precum Hive, Pig, Sqoop și HBase. Deci, dacă UDF este scris, poate fi folosit de oricare dintre aplicațiile menționate mai sus. Crește performanța și suportabilitatea sistemului.

- OPTIMIZAREA

Hadoop stochează date în HDFS și Process, deși Map Reduce cu tehnici de optimizare uriașe. Cele mai populare tehnici utilizate pentru manipularea datelor sunt utilizarea partitionării și ghetei datelor stocate. Partitionarea este o abordare pentru stocarea datelor în HDFS prin împărțirea datelor pe baza coloanei menționate pentru partiționare. Când datele sunt injectate sau încărcate în HDFS, identifică coloana de partiție și împinge datele în directorul de partiții în cauză. Deci interogarea preia setul de rezultate preluând direct datele din directorul partiționat. Aceasta reduce întreaga scanare a tabelului, îmbunătățește timpul de răspuns și evită latența.

O altă abordare se numește Bucketing de date. Aceasta permite analistului să distribuie cu ușurință datele între nodurile de date. Toate nodurile vor avea un număr egal de date distribuite. Coloana de găleată este selectată astfel încât să aibă cel mai mic număr de cardinalitate.

Aceste abordări nu sunt disponibile în metoda tradițională a SQL.

- TIP DE DATE

Într-o abordare tradițională, tipul de date acceptat este foarte limitat. Nu acceptă decât date structurate. Astfel, pentru a curăța și a forma schema de date în sine va dura mai mult timp. Dar, Hadoop acceptă tipuri de date complexe precum Array, Struct și Map. Acest lucru încurajează utilizarea diferitelor tipuri de set de date care pot fi utilizate pentru încărcarea datelor. Pentru Ex: datele XML pot fi încărcate prin definirea datelor cu elemente XML care conțin tip de date complexe.

- COMPRESIUNEA DATELOR

Pentru sistemul tradițional de baze de date sunt foarte puține tehnici de compresie încorporate. Dar pentru cadrul Hadoop, există multe tehnici de compresie precum gzib, bzip2, LZO și snappy. Modul de compresie implicit este LZ4. Chiar și tabelele pot fi comprimate folosind tehnici de compresie precum Parchet, ORC. Tehnicile de compresie ajută la crearea de spații pentru ca tabelele să ocupe foarte puțin spațiu crește debitul și executarea rapidă a interogărilor.

Tabelul de comparare Hadoop Vs SQL

| caracteristici | SQL tradițional | Hadoop |

| Dimensiunea datelor | gigaocteţi | petabytes |

| Acces | Interactive & Lot | Lot |

| Actualizări | Citește și scrie - de mai multe ori | Scrie o dată, citește de mai multe ori |

| Structura | Schema statică | Schema dinamică |

| Integritate | Înalt | Scăzut |

| scalarea | Non-linear | Liniar |

Tabel : Comparație între Hadoop tradițional și SQL Framework.

Concluzie - Hadoop Vs SQL

În general, Hadoop se apropie de SQL-ul tradițional din punct de vedere al costului, timpului, performanței, fiabilității, suportabilității și disponibilității de date pentru grupul foarte mare de utilizatori. Pentru a gestiona eficient cantitatea uriașă de date generate în fiecare zi, cadrul Hadoop ajută la captarea, stocarea, procesarea, filtrarea și stocarea în timp util a acestora într-un loc centralizat.

Articol recomandat

- Hadoop vs Hive - Aflați cele mai bune diferențe

- Aflați cele 10 diferențe utile dintre Hadoop și Redshift

- HADOOP vs RDBMS | Cunoaște cele 12 diferențe utile

- Apache Hadoop vs Apache Spark | Top 10 comparații pe care trebuie să le știi!

- Hadoop vs Spark: Caracteristici