Diferența dintre Apache Storm și Apache Spark

Apache Storm este un sistem de calcul în timp real, scalabil, tolerant la erori și distribuit. Furtuna Apache este axată pe procesarea fluxului sau procesarea evenimentelor. Apache Storm pune în aplicare o metodă tolerantă la erori pentru efectuarea unei calculări sau realizarea de mai multe calcule pe un eveniment pe măsură ce se varsă într-un sistem. Apache Spark este un cadru de tehnologie de calcul rapid și fulger, conceput pentru calcul rapid pe prelucrarea datelor la scară largă. Apache Spark este un motor de procesare distribuit, dar nu vine cu un manager de resurse cluster incorporat și un sistem de stocare distribuit. Trebuie să conectați un manager de cluster și un sistem de stocare la alegere.

Prezentare mai mult despre Apache Storm vs Apache Spark:

- Apache Storm este un motor de calcul continuu paralel cu sarcina. Își definește fluxurile de lucru în Graficele aciclice direcționate (DAG) numite topologii. Aceste topologii rulează până la închiderea utilizatorului sau se confruntă cu un eșec care nu poate fi recuperat. Apache Storm nu rulează pe clusterele Hadoop, ci folosește Zookeeper și propriul său muncitor pentru a-și gestiona procesele. Apache Storm poate citi și scrie fișiere pe HDFS.

- Apache Storm se integrează cu tehnologiile de cozi și bazele de date pe care le utilizați deja. O topologie Storm consumă fluxuri de date și prelucrează aceste fluxuri în moduri arbitrar complexe, repartizând fluxurile între fiecare etapă a calculului, oricum este necesar. Furtuna Apache se bazează pe tupluri și fluxuri. Un tuple este practic care sunt datele dvs. și modul în care acestea sunt structurate.

- Cadrul Apache Spark este format din Spark Core și Set de biblioteci. Spark core execută și gestionează munca noastră oferind o experiență perfectă utilizatorului final. Un utilizator trebuie să trimită o lucrare către Spark core, iar Spark core se ocupă de prelucrarea ulterioară, executarea și răspunsul înapoi la utilizator. Avem API Spark Core în diferite limbaje de script, cum ar fi Scala, Python, Java și R.

- În Apache Spark, utilizatorul poate folosi Apache Storm pentru a transforma datele nestructurate, pe măsură ce acestea curg în formatul dorit. Trebuie să conectați un manager de cluster și un sistem de stocare la alegere.

- Puteți alege Apache YARN sau Mesos pentru managerul de cluster pentru Apache Spark.

- Puteți alege Sistemul de fișiere distribuit Hadoop (HDFS), Google cloud storage, Amazon S3, Microsoft Azure pentru managerul de resurse pentru Apache Spark.

- Apache Spark este un motor de procesare a datelor pentru modurile de lot și streaming, care conține interogări SQL, procesare grafică și învățare automată.

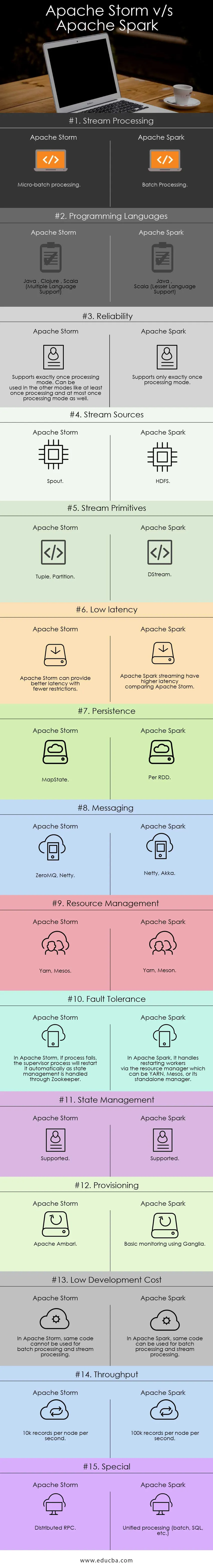

Comparație față în față între Apache Storm și Apache Spark (Infografie):

Diferențele cheie între Apache Storm și Apache Spark:

Mai jos sunt listele de puncte, descrieți diferențele cheie între Apache Storm și Apache Spark:

- Apache Storm efectuează calcule paralel-sarcină, în timp ce Apache Spark realizează calcule paralele cu date.

- Dacă nodul lucrător nu reușește în Apache Storm, Nimbus atribuie sarcina lucrătorilor celuilalt nod și toate tuplurile trimise unui nod eșuat vor fi cronometrate și, prin urmare, redate automat, în timp ce în Apache Spark, dacă nodul lucrător nu reușește, atunci sistemul poate re-calcula din copie rămasă a datelor de intrare și a datelor s-ar putea pierde dacă datele nu sunt reproduse.

- Garanția de livrare Apache Strom depinde de o sursă de date sigură, în timp ce în Apache Spark, sursa de date HDFS cu siguranță este sigură.

- Apache Storm este un motor de procesare în flux pentru procesarea datelor în streaming în timp real, în timp ce Apache Spark este un motor de calcul de uz general.

Caracteristici Apache Storm:

- Toleranță la defecțiuni - în cazul în care, în cazul în care firul lucrătorului moare, sau un nod scade, lucrătorii sunt reporniți automat

- Scalabilitate - Foarte scalabil, Storm poate menține performanța chiar și sub sarcină în creștere, adăugând resurse liniar, unde se pot atinge rate de transfer de chiar și un milion de 100 de octeți mesaje pe secundă pe nod.

- Latency - Storm efectuează reîmprospătarea datelor și răspunsul livrării de la capăt la sfârșit în câteva secunde sau minute depinde de problemă. Are latenta foarte scazuta.

- Ușor de utilizat în implementarea și operarea sistemului.

- Integrat cu Hadoop pentru a valorifica randamentele mai mari

- Ușor de implementat și poate fi integrat cu orice limbaj de programare

- Furtuna Apache este open source, robustă și ușor de utilizat. Poate fi utilizat în companii mici, precum și în corporații mari

- Permite procesarea fluxurilor în timp real într-un mod incredibil de rapid, deoarece și are o putere enormă de procesare a datelor.

- Furtuna Apache are inteligență operațională.

- Apache Storm oferă o prelucrare garantată a datelor, chiar dacă unul dintre nodurile conectate din cluster mor sau mesajele sunt pierdute

Caracteristici Apache Spark:

- Viteză: Apache Spark ajută la rularea unei aplicații în clusterul Hadoop, de până la 100 de ori mai rapid în memorie și de 10 ori mai rapid atunci când rulează pe disc.

- Prelucrare în timp real: scânteia Apache poate gestiona date de streaming în timp real.

- Utilizabilitate : Apache Spark are capacitatea de a susține mai multe limbi precum Java, Scala, Python și R

- Evaluarea Lazy: în Apache Spark, transformările sunt leneșe în natură. Acesta va da rezultat după formarea noului RDD din cel existent.

- Integrare cu Hadoop: Apache Spark poate rula independent și, de asemenea, pe Hadoop YARN Cluster Manager și astfel poate citi datele Hadoop existente.

- Toleranță la erori: Apache Spark asigură toleranță la erori folosind conceptul RDD. RDD-urile Spark sunt proiectate pentru a face față eșecului oricărui nod lucrător din cluster.

Apache Storm vs Apache Spark Table Table

Discut despre artefacte majore și disting între Apache Storm și Apache Spark.

| Furtuna Apache | Scânteie Apache | |

| Procesarea fluxului | Prelucrare micro-lot | Prelucrare lot |

| Limbaje de programare | Java, Clojure, Scala (suport pentru mai multe limbi) | Java, Scala (asistență pentru limbi mici) |

| Fiabilitate | Suporta exact o dată modul de procesare. Poate fi folosit și în celelalte moduri, cum ar fi cel puțin o dată procesarea și cel mult o dată, de asemenea, modul de procesare | Acceptă doar o singură dată modul de procesare |

| Surse de flux | canal de scurgere | HDFS |

| Primitive de flux | Tuple, partiție | DStream |

| Latenta scazuta | Furtuna Apache poate oferi o latență mai bună, cu mai puține restricții | Streamingul Apache Spark are o latență mai mare comparativ cu Apache Storm |

| persistență | MapState | Per RDD |

| Schimb de mesaje | ZeroMQ, Netty | Netty, Akka |

| Managementul resurselor | Fire, Mesos | Fire, Meson |

| Toleranță la erori | În Apache Storm, în cazul în care procesul eșuează, procesul de supraveghere îl va reporni automat, deoarece gestionarea de stat este gestionată prin Zookeeper | În Apache Spark, gestionează repornirea lucrătorilor prin intermediul managerului de resurse care poate fi YARN, Mesos sau managerul său autonom |

| Managementul statului | Sprijinit | Sprijinit |

| Provisioning | Apache Ambari | Monitorizare de bază cu Ganglie |

| Cost scăzut de dezvoltare | În Apache Storm, nu se poate utiliza același cod pentru procesarea lotului și procesarea fluxului | În Apache Spark, același cod poate fi utilizat pentru procesarea loturilor și procesarea fluxului |

| tranzitată | 10k înregistrări pe nod pe secundă | 100k înregistrări pe nod pe secundă |

| Special | RPC distribuit | Prelucrare unificată (lot, SQL etc.) |

Concluzie - Apache Storm vs Apache Spark:

Apache Storm și Apache Spark sunt soluții excelente care rezolvă problema de ingerare și transformare a fluxului. Apache Storm și Apache Spark pot fi parte a clusterului Hadoop pentru procesarea datelor. Furtuna Apache este o soluție pentru procesarea fluxului în timp real. Însă Storm este foarte complex pentru dezvoltatori să dezvolte aplicații din cauza resurselor limitate.

Apache Storm poate fi utilizat mai ales pentru procesarea fluxului. Dar industria are nevoie de o soluție generalizată care să poată rezolva toate tipurile de probleme. De exemplu, procesarea lotului, procesarea în flux a procesării interactive, precum și procesarea iterativă. Deci, Apache Spark vine în lumina reflectoarelor, care este un motor de calcul general. Acesta este motivul pentru care cererea Apache Spark se compară mai mult cu alte instrumente ale profesioniștilor IT. Apache Spark poate rezolva diferite tipuri de probleme. În afară de acest Apache Spark este mult prea ușor pentru dezvoltatori și se poate integra foarte bine cu Hadoop. Apache Spark vă oferă flexibilitatea de a lucra în diferite limbi și mediu.

Articol recomandat

Acesta a fost un ghid pentru Apache Storm vs Apache Spark, semnificația lor, comparația dintre cap și cap, diferențele cheie, tabelul de comparație și concluzii. De asemenea, puteți consulta următoarele articole pentru a afla mai multe -

- Iaas vs Azure Pass - Diferențele pe care trebuie să le știi

- Apache Hadoop vs Apache Spark | Top 10 comparații pe care trebuie să le știi!

- 7 Ghid uimitor despre Despre Apache Spark (Ghid)

- Cele mai bune 15 lucruri pe care trebuie să le știi despre MapReduce vs Spark

- Hadoop vs Apache Spark - Lucruri interesante pe care trebuie să le știi