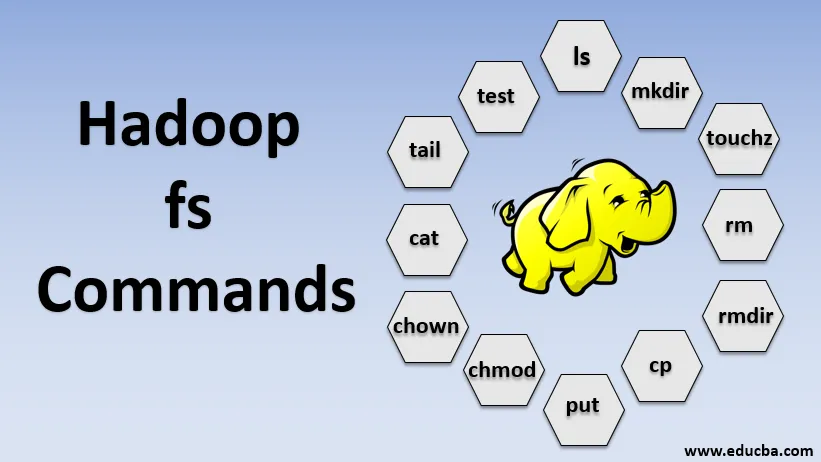

Introducere în Comenzile Hadoop fs

În acest articol, vom parcurge comenzile de gestionare a fișierelor de la HADOOP, care este utilizat pentru gestionarea fișierelor prin consolă.

Veți avea nevoie de un sistem Linux și de cea mai recentă versiune Hadoop. Pentru a tipări versiunea Hadoop, pentru a cunoaște de la cine a fost construită versiunea, valoarea de checkum trebuie doar să executăm comanda de mai jos după conectarea la platforma Hadoop.

Comandă: versiunea Hadoop

Poruncile lui Hadoop fs

Acum, să învățăm cum să utilizăm comenzile HADOOP fs.

Vom începe cu elementele de bază. Trebuie doar să introduceți aceste comenzi în PUTTY sau în orice consolă cu care sunteți confortabil.

1. hadoop fs -ls

Pentru un director, returnează lista de fișiere și directoare, în timp ce, pentru un fișier, returnează statisticile din fișier.

hadoop fs -lsr: aceasta este pentru listarea recursivă a directoarelor și fișierelor în anumite dosare.

- Exemplu : hadoop fs -ls / sau hadoop fs -lsr

- -d: Acesta este utilizat pentru a lista directoarele ca fișiere simple.

- -h: Acesta este utilizat pentru a format dimensiunile fișierelor într-un mod care poate fi citit de om decât numărul de octeți.

- -R: Acesta este utilizat pentru a lista recursiv conținutul directoarelor.

2. hadoop fs -mkdir

Această comandă ia calea ca argument și creează directoare în hdfs.

- Exemplu : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Creează un fișier gol și nu folosește spațiu

- Exemplu: hadoop fs -touchz URI

4. hadoop fs -rm

Ștergeți fișierele specificate ca argument. Trebuie să specificăm opțiunea -r pentru a șterge întregul director. Și dacă opțiunea -skipTrash este specificată, va omite gunoiul și fișierul va fi șters imediat.

- Exemplu : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Elimina fișierele și permisiunile directoarelor și subdirectorilor. Practic, este versiunea extinsă a Hadoop fs -rm.

6. hadoop fs -cp

Copiază fișierul dintr-o locație în alta

- Exemplu : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Copiază fișierul de la edgenode la HDFS.

8. hadoop fs -put

Copiază fișierul de la edgenode la HDFS, este similar cu comanda precedentă, dar pune și citirea intrării de la stdin-ul de intrare standard și scrie la HDFS

- Exemplu : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Steagul păstrează accesul, timpul de modificare, proprietatea și modul.

hadoop fs -put -f: Această comandă suprascrie destinația dacă fișierul există deja înainte de copiere.

9. hadoop fs -moveFromLocal

Este similar cu copierea din local, cu excepția faptului că fișierul sursă este șters din edgenode locale după ce este copiat pe HDFS

- Exemplu : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Copiază fișierul de la HDFS în edgenode.

- Exemplu : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Această comandă ne ajută să schimbăm accesul unui fișier sau director

- Exemplu : hadoop fs -chmod (-R) (calea)

12. hadoop fs -chown

Această comandă ne ajută să schimbăm proprietatea unui fișier sau a unui director

- Exemplu : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PATH

13. hadoop fs -cat

Acesta imprimă conținutul unui fișier HDFS pe terminal

- Exemplu : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Afișează ultimul KB al fișierului HDFS la stdout

- Exemplu : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Această comandă este folosită pentru operațiile de testare a fișierelor HDFS, returnează 0 dacă este adevărat.

- - e: verifică dacă fișierul există.

- -z: verifică dacă fișierul are o lungime zero

- -d / -f: verifică dacă calea este directorul / respectiv fișierul

Aici, discutăm un exemplu în detaliu

- Exemplu : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Afișează dimensiuni de fișiere și directoare conținute în directorul dat sau lungimea unui fișier în cazul în care acesta este un fișier

17. hadoop fs -df

Afișează spațiu liber

18. hadoop fs -checksum

Returnează informațiile despre sumele de control ale unui fișier

19. hadoop fs -getfacl

Afișează lista de control de acces (ACL) a fișierului sau directorului

20. hadoop fs -count

Numără numărul de directoare, fișiere și octeți sub calea care se potrivește cu modelul de fișier specificat.

21. hadoop fs -setrep

Modifică factorul de replicare a unui fișier. Și dacă calea este un director, atunci comanda schimbă factorul de replicare a tuturor fișierelor din director.

- Exemplu : hadoop fs -setrep -R / user / datahub: este utilizat pentru a accepta capacitatea de întoarcere și nu are efect.

hadoop fs - setrep -w / user / datahub : așteaptă finalizarea replicării

22. hadoop fs -getmerge

Acesta concatenează fișierele HDFS din sursă în fișierul local de destinație

- Exemplu : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Anexează o singură sursă sau mai multe surse din sistemul de fișiere local la destinație.

- Exemplu : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Tipărește statisticile despre fișier sau director.

- Exemplu : hadoop fs -stat (format)

Concluzie - Comenzi Hadoop fs

Astfel, am trecut prin aproape toate comenzile care sunt necesare pentru gestionarea fișierelor și vizualizarea datelor din fișiere. Puteți modifica fișierele și ingera date în platforma Hadoop acum.

Articole recomandate

Acesta este un ghid pentru Comenzile Hadoop fs. Aici discutăm despre introducerea comenzilor fs Hadoop împreună cu exemplul său în detaliu. De asemenea, puteți consulta următoarele articole pentru a afla mai multe-

- Instalați Hadoop

- Instrumente Hadoop

- Arhitectura Hadoop

- Componente Hadoop

- Hadoop fs Commands