Ce este Ecosistemul Apache Hadoop?

Apache Hadoop Ecosystem este un cadru sau o platformă de date open-source alocată pentru a salva și examina colecțiile uriașe de date nestructurate. În întreaga lume, există o mulțime de date care sunt propulsate din numeroase platforme digitale cu tehnologia de inovare de top a datelor. Mai mult, Apache Hadoop a fost primul care a obținut acest flux de inovație.

Ce cuprinde arhitectura / ecosistemul Hadoop Data?

Ecosistemul Hadoop nu este un limbaj de programare sau un serviciu, ci este un cadru sau o platformă care se ocupă de problemele de date mari. Îl poți identifica ca o suită care învelește diverse servicii, cum ar fi stocarea, ingerarea, întreținerea și analiza în interiorul acesteia. Apoi, examinați și gândiți-vă concis despre modul în care serviciile funcționează exclusiv și în cooperare. Arhitectura Apache Hadoop cuprinde diferite inovații și elemente Hadoop prin care chiar și problemele informaționale complicate pot fi rezolvate eficient.

Urmărește prezentarea fiecărei părți: -

1) Namenod: Ghidează procesul de informare

2) Datanode: Compune informațiile pentru stocarea locală. Pentru a salva toate informațiile la un loc singular nu se sugerează continuu, deoarece ar putea cauza pierderea informațiilor în caz de criză.

3) Urmărirea sarcinilor: primesc taxele alocate nodului sclav

4) Harta: Este nevoie de informații dintr-un flux și fiecare linie este tratată împărțită pentru a o împărți în câmpuri diferite

5) Diminuează: Aici câmpurile dobândite prin Harta sunt adunate sau legate între ele

Ecosistemul Apache Hadoop - pas cu pas

Fiecare element al ecosistemului Hadoop, deoarece aspectele specifice sunt evidente. Perspectiva cuprinzătoare asupra structurii Hadoop oferă o calitate remarcabilă sistemelor de fișiere distribuite Hadoop (HDFS), Hadoop YARN, Hadoop MapReduce și Hadoop MapReduce din ecosistemul Hadoop. Hadoop oferă fiecărei biblioteci Java, înregistrări Java semnificative, reflectare la nivel de sistem de operare, avantaje și scripturi pentru a opera Hadoop, Hadoop YARN este o metodă pentru conturarea afacerilor și gestionarea resurselor buchete. În configurația Hadoop, HDFS oferă o trecere mare a informațiilor despre aplicație, iar Hadoop MapReduce oferă pregătirea paralelă bazată pe YARN pentru sortimente extinse de date.

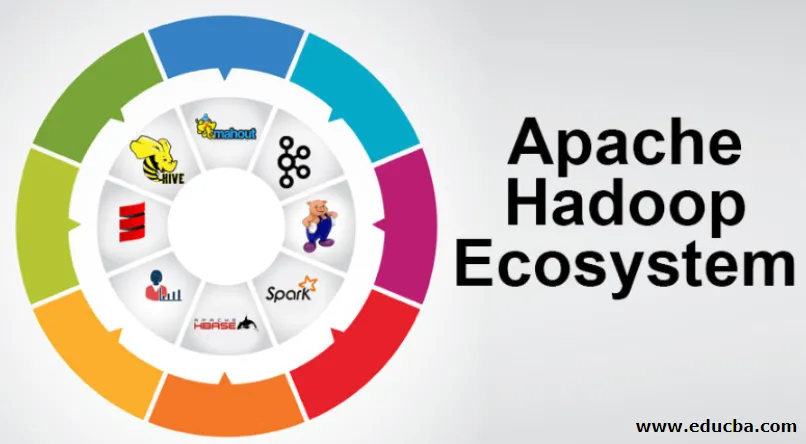

Prezentare generală a ecosistemului Apache Hadoop

Este un subiect fundamental de înțeles înainte de a începe să lucrați cu ecosistemul Hadoop. Mai jos sunt componentele esențiale:

- HDFS: Aceasta este partea centrală a ecosistemului Hadoop și poate economisi o cantitate enormă de informații nestructurate, structurate și semi-structurate.

- YARN: seamănă cu mintea ecosistemului Hadoop și toate manipulările se desfășoară direct aici, care poate încorpora alocarea de active, planificarea lucrărilor și pregătirea acțiunilor.

- MapReduce: este un amestec de două procese, descrise ca Map și Reduce și cuprinde în esență pregătirea pieselor care compun colecții informaționale uriașe care folosesc algoritmi paraleli și dispersi în ecosistemul Hadoop.

- Apache Pig: este un limbaj al procedurii, care este utilizat pentru aplicații de manipulare paralelă pentru a procesa vaste colecții informaționale în condiții Hadoop, iar acest limbaj este o opțiune pentru programarea Java.

- HBase: este o bază de date open-source și o bază de date ne-asociată sau NoSQL. Acesta susține toate tipurile de informații, astfel pot trata orice tip de informații din cadrul cadrului Hadoop.

- Mahout, Spark MLib: Mahout este utilizat pentru învățarea automată și dă natura creării de aplicații de învățare automată.

- Zookeeper: Pentru a face față grupurilor, se poate utiliza Zookeeper, altfel se numește lordul coordonării, care poate oferi administrații operaționale fiabile, rapide și sortate pentru grupurile Hadoop.

- Oozie: Apache Oozie operează planificarea lucrărilor și operează ca servicii de alertă și ceas în interiorul ecosistemului Hadoop.

- Ambari: Este o întreprindere a Apache Software Foundation și poate realiza ecosistemul Hadoop flexibil progresiv.

HADOOP HARN:

Gândiți-vă la YARN ca la mintea ecosistemului vostru Hadoop. Acesta joacă integral operațiunile de procesare alocând activele și sarcinile de planificare.

Are două segmente de remarcat, care sunt ResourceManager și NodeManager.

- ResourceManager: - Este din nou un nod major în divizia de operare. Acesta primește anchetele de pregătire și, după aceea, trece la întrebările referitoare la NodeManagers, respectiv acolo unde are loc manipularea autentică.

- NodeManagers: - Acestea sunt instalate pe fiecare DataNode. Acesta este responsabil de executarea unei misiuni pe fiecare DataNode.

Cum funcționează apache Hadoop?

- Este destinat să urce de la servere individuale la o cantitate uriașă de mașini, fiecare oferind calcul și capacitate locală. În loc să depindă de echipamentul pentru a transmite accesibilitate ridicată, biblioteca în sine este destinată să distingă și să facă față dezamăgirilor la nivelul aplicației, astfel încât să transmită un serviciu extrem de accesibil pe o grămadă de PC-uri, fiecare dintre ele putând fi înclinat spre dezamăgiri.

- Privește mai departe, cu toate acestea, există un farmec în creștere semnificativă la locul de muncă. Hadoop este total modular, ceea ce implică faptul că puteți schimba practic oricare dintre segmentele sale pentru un instrument software alternativ. Acest lucru face ca arhitectura să fie adaptabilă fantastic, la fel de puternică și eficientă.

Apache Hadoop Spark:

- Apache Spark este un sistem pentru analiza informațiilor în timp real într-un cadru de calcul dispersat. Implementează calcule în memorie pentru a construi viteza de gestionare a informațiilor.

- Este mai rapid pentru manipularea informațiilor la scară largă, deoarece utilizează calcule în memorie și îmbunătățiri diferite. De-a lungul acestor linii, necesită forță ridicată de procesare.

Cum funcționează Apache Pig?

- Apache Pig este un sistem benefic Yahoo a fost dezvoltat pentru a examina pozițiile informaționale vaste în mod eficient și fără probleme. Oferă câteva informații de nivel superior de limbă de porc Latin, care este îmbunătățit, extensibil și simplu de utilizat.

- Componenta excepțională a programelor Pig în care compoziția lor este disponibilă pentru o paralelizare substanțială, ceea ce face simplă îngrijirea colecțiilor informaționale substanțiale.

Cuză de utilizare a porcilor:

- Informațiile private de asistență medicală ale unei persoane sunt private și nu ar trebui să fie dezvăluite altor persoane. Aceste date ar trebui ascunse pentru a păstra secretul, dar informațiile privind serviciile medicamentoase sunt uriașe până la recunoașterea și excluderea informațiilor individuale de asistență medicală. Apache Pig poate fi utilizat în astfel de condiții pentru a recunoaște datele de sănătate.

Concluzie:

- Este conturat să urce de la un singur server la o cantitate uriașă de mașini, toate oferind calcule și capacitate în apropiere. Uită-te mai departe, totuși, și la locul de muncă este mult mai fermecător.

- Hadoop este total modular, ceea ce implică faptul că puteți comercializa practic oricare dintre părțile sale pentru un instrument software alternativ. Aceasta face ca structura să fie adaptabilă fantastic, la fel de puternică și de eficientă.

Articole recomandate

Acesta a fost un ghid pentru Ecosistemul Apache Hadoop. Aici am discutat despre ce este Ecosistemul Apache Hadoop? imagine de ansamblu asupra arhitecturii Hadoop și a funcționării ecosistemului Hadoop. Puteți parcurge și alte articole sugerate pentru a afla mai multe -

- Componentele ecosistemului Hadoop

- Cum se instalează Apache

- Antrenament de scânteie Apache

- Cariera în Hadoop