Introducere în cadrul Hadoop Framework

Înainte de a ne afunda adânc în cadrul tehnic al Hadoop, vom începe cu un exemplu simplu.

Există o fermă care recoltează roșii și le depozitează într-o singură zonă de depozitare, acum, odată cu cererea din ce în ce mai mare de legume, ferma a început să recolteze cartofi, morcovi - cu cererea din ce în ce mai mare, a existat un deficit de fermieri, astfel încât au angajat mai mulți fermieri. După ceva timp și-au dat seama că există o penurie în zona de depozitare - așa că au distribuit legumele în diferite zone de depozitare. Când vine vorba de preluarea datelor, toate lucrează în paralel cu propriul spațiu de stocare.

Deci, cum este legată această poveste cu datele mari?

Mai devreme aveam date limitate, cu procesorul limitat și o unitate de stocare. Dar apoi generarea de date a crescut ducând la volum mare și la diferite soiuri - structurate, semi-structurate și nestructurate, deci soluția a fost să folosiți stocarea distribuită pentru fiecare procesor, ceea ce a permis accesul ușor la stocare și acces la date.

Deci, acum putem înlocui legumele ca tipuri diferite de date și loc de depozitare ca locurile distribuite pentru stocarea datelor și diferiți lucrători fiind fiecare procesor.

Deci Big Data este provocarea, iar Hadoop joacă rolul Soluției.

Hadoop

1. Soluție pentru BIG DATA: deoarece tratează complexități de volum mare, viteză și varietate de date.

2. Setul proiectului open-source.

3. Stochează un volum imens de date în mod fiabil și permite calcule imense distribuite.

4. Atributele cheie ale lui Hadoop sunt redundanța și fiabilitatea (absolut nicio pierdere de date).

5. Se concentrează în principal pe procesarea lotului.

6. Utilizează hardware-ul de marfă - nu trebuie să cumpărați hardware special scump.

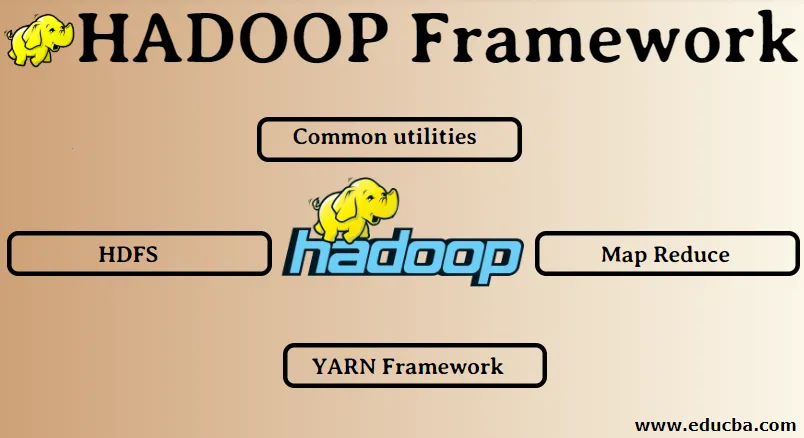

Cadrul Hadoop:

1. Utilități comune

2. HDFS

3. Reduceți harta

4. Cadrul YARN

1. Utilități comune:

Numită și comună Hadoop. Acestea nu sunt altceva decât bibliotecile, fișierele, scripturile și utilitățile JAVA care sunt de fapt necesare celorlalte componente Hadoop pentru a le efectua.

2. HDFS: Sistem de fișiere distribuit Hadoop

De ce Hadoop a ales să încorporeze un sistem de fișiere distribuit?

Să înțelegem acest lucru cu un exemplu: trebuie să citim 1 TB de date și avem o singură mașină cu 4 canale I / O fiecare canal având 100 MB / s, a fost nevoie de 45 de minute pentru a citi datele întregi. Acum, aceeași cantitate de date este citită de 10 mașini fiecare cu 4 canale I / O fiecare canal având 100 MB / s. Ghiciți timpul necesar pentru citirea datelor? 4, 3 minute. HDFS rezolvă problema stocării datelor mari. Cele două componente principale ale HDFS sunt NAME NODE și DATA NODE. Nodul de nume este maestru, este posibil să avem un nod secundar, de asemenea, în cazul în care nodul de nume principal nu mai funcționează nodul de nume secundar va acționa ca o rezervă. Nodul nume menține practic și gestionează nodurile de date stocând metadate. Nodul de date este sclavul, care este practic hardware-ul de marfă cu costuri reduse. Putem avea mai multe noduri de date. Nodul de date stochează datele reale. Acest nod de date acceptă factorul de replicare, să presupunem că dacă un nod de date coboară, atunci datele pot fi accesate de celălalt nod de date replicat, prin urmare, accesibilitatea datelor este îmbunătățită și pierderea datelor.

3. Reduceți harta:

Rezolvă problema procesării datelor mari. Să înțelegem că conceptul de hartă reduce prin rezolvarea acestei probleme din lumea reală. Compania ABC dorește să își calculeze vânzările totale, înțelept în oraș. Acum, aici, conceptul de tabel hash nu va funcționa, deoarece datele sunt în terabyte, așa că vom folosi conceptul Map-Reduce.

Există două faze: a) HARTA. b) REDUCERE

a) Harta : În primul rând, vom împărți datele în bucăți mai mici numite mappers pe baza perechii cheie / valoare. Deci, aici cheia va fi numele orașului, iar valoarea va fi vânzările totale. Fiecare mapper va obține date în fiecare lună care oferă un nume de oraș și vânzările corespunzătoare.

b) Reduce: Va obține aceste grămezi de date și fiecare reductor va fi responsabil pentru orașele Nord / Vest / Est / Sud. Astfel, munca reductorului va fi colectarea acestor bucăți mici și transformarea în cantități mai mari (prin adăugarea lor) pentru un anumit oraș.

4.YARN Framework: Încă un alt negociator de resurse.

Versiunea inițială a Hadoop avea doar două componente: Map Reduce și HDFS. Ulterior s-a realizat că Map Reduce nu a putut rezolva o mulțime de mari probleme de date. Ideea a fost să scoateți responsabilitățile de gestionare a resurselor și de planificare a locurilor de muncă de la vechea motorizare de reducere a hărții și să o dați unei noi componente. Așa se face că IARN a apărut în imagine. Este stratul mijlociu dintre HDFS și Map Reduce, care este responsabil pentru gestionarea resurselor de cluster.

Trebuie să îndeplinească două roluri cheie: a) Planificarea posturilor. b) Managementul resurselor

a) Planificarea locurilor de muncă: când o cantitate mare de date oferă pentru prelucrare, aceasta trebuie distribuită și defalcată în diferite sarcini / locuri de muncă. Acum, JS decide ce job trebuie să i se acorde prioritate maximă, intervalul de timp între două locuri de muncă, dependența dintre joburi, verifică dacă nu există nicio suprapunere între lucrările rulate.

b) Managementul resurselor: pentru prelucrarea datelor și pentru stocarea datelor, avem nevoie de resurse, nu? Deci managerul de resurse furnizează, administrează și întreține resursele pentru stocarea și procesarea datelor.

Deci, acum suntem clar despre conceptul de Hadoop și cum rezolvă provocările create de BIG DATA !!!

Articole recomandate

Acesta a fost un ghid al Cadrului Hadoop. Aici am discutat și despre cele mai bune 4 cadre Hadoop. Puteți parcurge și alte articole sugerate pentru a afla mai multe -

- Baza de date Hadoop

- Ecosistemul Hadoop

- Utilizările Hadoop

- Hadoop Administrator Locuri de muncă

- Administratorul Hadoop | Competențe și cale de carieră