Introducere în algoritmul AdaBoost

Algoritmul AdaBoost poate fi utilizat pentru a spori performanțele oricărui algoritm de învățare automată. Învățarea automată a devenit un instrument puternic care poate face predicții pe baza unei cantități mari de date. A devenit atât de popular în vremurile recente încât aplicarea învățării automate poate fi găsită în activitățile noastre de zi cu zi. Un exemplu obișnuit este obținerea de sugestii pentru produse în timp ce cumpărături online pe baza articolelor anterioare cumpărate de client. Mașina de învățare, adesea denumită analiză predictivă sau modelare predictivă poate fi definită ca capacitatea computerelor de a învăța fără a fi programată explicit. Utilizează algoritmi programați pentru a analiza datele de intrare pentru a prezice ieșirea într-un interval acceptabil.

Ce este algoritmul AdaBoost?

În învățarea automată, stimularea a pornit de la întrebarea dacă un set de clasificatori slabi ar putea fi convertiți într-un clasificator puternic. Învățător slab sau clasificator este un elev care este mai bun decât ghicirea aleatorie și acest lucru va fi robust în adaptare excesivă ca într-un set mare de clasificatoare slabe, fiecare clasificator slab fiind mai bun decât aleatoriu. Ca clasificator slab, în general este utilizat un prag simplu pe o singură caracteristică. Dacă caracteristica este peste prag decât cea prevăzută, aceasta aparține pozitivului, altfel aparține negativului.

AdaBoost înseamnă „Adaptive Boosting” care transformă elevii slabi sau predictorii în predictori puternici pentru a rezolva problemele de clasificare.

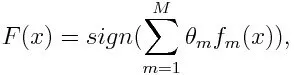

Pentru clasificare, ecuația finală poate fi pusă după cum urmează:

Aici f m desemnează cel mai slab clasificator și m reprezintă greutatea corespunzătoare.

Cum funcționează AdaBoost Algoritm?

AdaBoost poate fi utilizat pentru a îmbunătăți performanța algoritmilor de învățare automată. Este folosit cel mai bine la cursanții slabi și aceste modele obțin o precizie ridicată peste șansa întâmplătoare la o problemă de clasificare. Algoritmii comuni cu AdaBoost utilizate sunt arbori de decizie cu primul nivel. Un cursant slab este un clasificator sau un predictor care are performanțe relativ slabe din punct de vedere al exactității. De asemenea, se poate presupune că elevii slabi sunt ușor de calculat și multe cazuri de algoritmi sunt combinate pentru a crea un clasificator puternic prin impulsionare.

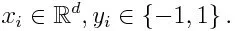

Dacă luăm un set de date care conține n număr de puncte, luăm în considerare cele de mai jos

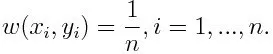

-1 reprezintă clasa negativă și 1 indică pozitiv. Este inițializat ca mai jos, greutatea pentru fiecare punct de date ca:

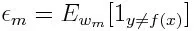

Dacă avem în vedere iterația de la 1 la M pentru m, vom obține expresia de mai jos:

În primul rând, trebuie să selectăm clasificatorul slab cu cea mai mică pondere de eroare de clasificare, încadrând clasificatorii slabi la setul de date.

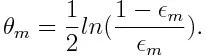

Apoi calculați greutatea pentru cel mai slab clasificator ca mai jos:

Greutatea este pozitivă pentru orice clasificator cu o precizie mai mare de 50%. Greutatea devine mai mare dacă clasificatorul este mai precis și devine negativ dacă clasificatorul are o precizie mai mică de 50%. Predicția poate fi combinată prin inversarea semnului. Prin inversarea semnului predicției, un clasificator cu o precizie de 40% poate fi transformat într-o precizie de 60%. Deci, clasificatorul contribuie la predicția finală, chiar dacă se realizează mai prost decât ghicirea aleatorie. Totuși, predicția finală nu va avea nicio contribuție și nu va primi informații de la clasificator cu o precizie exactă de 50%. Termenul exponențial din numărător este întotdeauna mai mare decât 1 pentru un caz clasificat greșit din clasificatorul ponderat pozitiv. După iterare, cazurile clasificate greșit se actualizează cu greutăți mai mari. Clasificatorii ponderați negativ se comportă la fel. Există însă o diferență că după ce semnul este inversat; clasificările corecte inițial s-ar transforma în clasificare greșită. Predicția finală poate fi calculată luând în considerare fiecare clasificator și apoi executând suma predicției lor ponderate.

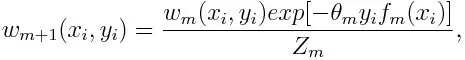

Actualizarea ponderii pentru fiecare punct de date, ca mai jos:

Z m este aici factorul de normalizare. Se asigură că suma totală a tuturor ponderilor instanței devine egală cu 1.

Pentru ce se utilizează algoritmul AdaBoost?

AdaBoost poate fi utilizat pentru detectarea feței, deoarece pare a fi algoritmul standard pentru detectarea feței în imagini. Utilizează o cascadă de respingere formată din mai multe straturi de clasificatoare. Când fereastra de detectare nu este recunoscută la niciun strat ca față, aceasta este respinsă. Primul clasificator din fereastră aruncă fereastra negativă, păstrând costurile de calcul la minimum. Deși AdaBoost combină clasificatorii slabi, principiile AdaBoost sunt, de asemenea, utilizate pentru a găsi cele mai bune caracteristici de utilizat în fiecare strat al cascadei.

Pro și contra algoritmului AdaBoost

Unul dintre numeroasele avantaje ale algoritmului AdaBoost este faptul că este rapid, simplu și ușor de programat. De asemenea, are flexibilitatea de a fi combinat cu orice algoritm de învățare automată și nu este necesară ajustarea parametrilor, cu excepția lui T. A fost extins la problemele de învățare dincolo de clasificarea binară și este versatil, deoarece poate fi folosit cu text sau numeric date.

AdaBoost prezintă, de asemenea, puține dezavantaje, cum ar fi din dovezi empirice și deosebit de vulnerabile la zgomotul uniform. Clasificatorii slabi, fiind prea slabi, pot duce la marje reduse și la supraadaptare.

Exemplu de algoritm AdaBoost

Putem lua în considerare un exemplu de admitere a studenților la o universitate unde fie ei vor fi admiși sau refuzați. Aici datele cantitative și calitative pot fi găsite din diferite aspecte. De exemplu, rezultatul admiterii care poate fi da / nu poate fi cantitativ, în timp ce orice alt domeniu precum abilitățile sau hobby-urile elevilor poate fi calitativ. Putem veni cu ușurință cu clasificarea corectă a datelor de formare la o mai bună decât șansa unor condiții, cum ar fi dacă studentul este bun la un anumit subiect, atunci este admis. Dar este dificil să găsești o predicție extrem de precisă și atunci elevii slabi vin în imagine.

Concluzie

AdaBoost ajută la alegerea setului de pregătire pentru fiecare nou clasificator care este instruit pe baza rezultatelor clasificatorului precedent. De asemenea, combinând rezultatele; determină cât de multă greutate trebuie acordată răspunsului propus de fiecare clasificator. Acesta combină elevii slabi pentru a crea unul puternic pentru a corecta erorile de clasificare, care este, de asemenea, primul algoritm stimulant de succes pentru problemele de clasificare binară.

Articole recomandate

Acesta a fost un ghid pentru algoritmul AdaBoost. Aici am discutat Conceptul, Utilizările, Lucrul, Pro și Contra cu Exemplu. De asemenea, puteți parcurge și celelalte articole sugerate pentru a afla mai multe -

- Algoritmul Naive Bayes

- Întrebări pentru interviuri de social media

- Strategii de construire a legăturilor

- Platforma de marketing social media