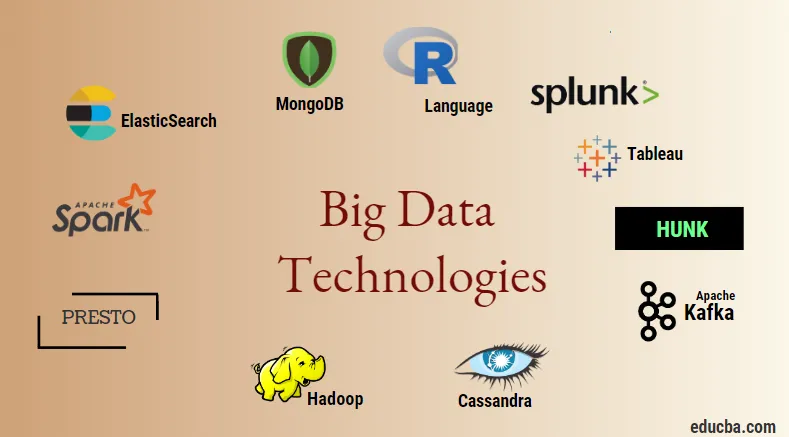

Introducere în tehnologiile Big Data

Tehnologia de date mari și Hadoop este un cuvânt cheie mare, așa cum ar putea suna. Întrucât a existat o creștere uriașă a domeniului de date și informații din fiecare industrie și domeniu, devine foarte importantă stabilirea și introducerea unei tehnici eficiente care să aibă grijă de toate nevoile și cerințele clienților și marilor industrii care sunt responsabile de generarea de date. . Anterior, datele erau gestionate de limbaje de programare normale și de limbaj de interogare structurat simplu, dar acum aceste sisteme și instrumente nu par să facă mare lucru în cazul datelor mari. Tehnologia de date mari este definită ca tehnologia și un utilitar software conceput pentru analiza, procesarea și extragerea informațiilor dintr-un set mare de structuri extrem de complexe și seturi de date mari, care este foarte dificil pentru sistemele tradiționale de a face față. Tehnologia de date mari este utilizată pentru a gestiona atât datele în timp real, cât și cele referitoare la lot. Învățarea automată a devenit o componentă foarte critică a vieții de zi cu zi și a fiecărei industrii și, prin urmare, gestionarea datelor prin date mari devine foarte importantă.

Tipuri de tehnologii de date mari

Înainte de a începe cu lista de tehnologii, să vedem mai întâi clasificarea largă a tuturor acestor tehnologii. Acestea pot fi clasificate în principal în 4 domenii.

- Stocare a datelor

- Google Analytics

- Minerirea datelor

- Vizualizare

Să acoperim mai întâi toate tehnologiile care intră sub umbrela de stocare.

1. Hadoop : Când vine vorba de date mari, Hadoop este prima tehnologie care intră în joc. Aceasta se bazează pe arhitectura de reducere a hărții și ajută la procesarea lucrărilor legate de lot și la procesarea informațiilor lot. Acesta a fost proiectat pentru a stoca și prelucra datele într-un mediu distribuit de prelucrare a datelor împreună cu hardware-ul mărfii și un model simplu de execuție a programării. Poate fi folosit pentru a stoca și analiza datele prezente în diferite mașini diferite, cu stocare, viteză și costuri reduse. Aceasta este una dintre componentele principale ale tehnologiei de date mari, care a fost dezvoltată de fundația software Apache în anul 2011 și este scrisă în Java.

1. Hadoop : Când vine vorba de date mari, Hadoop este prima tehnologie care intră în joc. Aceasta se bazează pe arhitectura de reducere a hărții și ajută la procesarea lucrărilor legate de lot și la procesarea informațiilor lot. Acesta a fost proiectat pentru a stoca și prelucra datele într-un mediu distribuit de prelucrare a datelor împreună cu hardware-ul mărfii și un model simplu de execuție a programării. Poate fi folosit pentru a stoca și analiza datele prezente în diferite mașini diferite, cu stocare, viteză și costuri reduse. Aceasta este una dintre componentele principale ale tehnologiei de date mari, care a fost dezvoltată de fundația software Apache în anul 2011 și este scrisă în Java.

2. MongoDB : O altă componentă esențială și esențială a tehnologiei de date mari în ceea ce privește stocarea este baza de date NoSQL MongoDB. Este o bază de date NoSQL, ceea ce înseamnă că proprietățile relaționale și alte proprietăți legate de RDBMS nu se aplică acesteia. Este diferit de bazele de date tradiționale RDBMS, care utilizează un limbaj de interogare structurat. Utilizează documente de schemă, iar structura de stocare a datelor este de asemenea diferită și, prin urmare, sunt utile în reținerea unei cantități mari de date. Este un program de baze de date orientat pe documente și baze de date, care utilizează documente JSON precum și schema. Acesta devine un caz de utilizare foarte util al magazinelor de date operaționale din majoritatea instituțiilor financiare și, prin urmare, lucrează la înlocuirea mainframe-urilor tradiționale. MongoDB gestionează flexibilitatea și, de asemenea, o mare varietate de tipuri de date la volume mari și printre arhitecturi distribuite.

2. MongoDB : O altă componentă esențială și esențială a tehnologiei de date mari în ceea ce privește stocarea este baza de date NoSQL MongoDB. Este o bază de date NoSQL, ceea ce înseamnă că proprietățile relaționale și alte proprietăți legate de RDBMS nu se aplică acesteia. Este diferit de bazele de date tradiționale RDBMS, care utilizează un limbaj de interogare structurat. Utilizează documente de schemă, iar structura de stocare a datelor este de asemenea diferită și, prin urmare, sunt utile în reținerea unei cantități mari de date. Este un program de baze de date orientat pe documente și baze de date, care utilizează documente JSON precum și schema. Acesta devine un caz de utilizare foarte util al magazinelor de date operaționale din majoritatea instituțiilor financiare și, prin urmare, lucrează la înlocuirea mainframe-urilor tradiționale. MongoDB gestionează flexibilitatea și, de asemenea, o mare varietate de tipuri de date la volume mari și printre arhitecturi distribuite.

3. Hunk : este util în accesarea datelor prin clusterele Hadoop de la distanță, utilizând indexuri virtuale și folosește, de asemenea, un limbaj de procesare a căutării Splunk care poate fi utilizat pentru analiza datelor. Hunk-ul poate fi utilizat pentru a raporta și vizualiza cantități uriașe de date din bazele de date și surse Hadoop și NoSQL. A fost dezvoltat de echipa Splunk în anul 2013, care a fost scris în Java.

3. Hunk : este util în accesarea datelor prin clusterele Hadoop de la distanță, utilizând indexuri virtuale și folosește, de asemenea, un limbaj de procesare a căutării Splunk care poate fi utilizat pentru analiza datelor. Hunk-ul poate fi utilizat pentru a raporta și vizualiza cantități uriașe de date din bazele de date și surse Hadoop și NoSQL. A fost dezvoltat de echipa Splunk în anul 2013, care a fost scris în Java.

4. Cassandra : Cassandra constituie o alegere de top printre lista de baze de date populare NoSQL, care este o bază de date gratuită și open-source, care este distribuită și are un depozit columnar larg și poate gestiona în mod eficient datele privind clusterele de mărfuri mari, adică este folosită asigura disponibilitate ridicata impreuna cu niciun punct de esec. Printre principalele caracteristici se numără cele precum natura distribuită, scalabilitatea, mecanismul tolerant la erori, suportul MapReduce, consistența reglabilă, proprietatea limbajului de interogare, acceptă replicarea mai multor centre de date și coerența eventuală.

4. Cassandra : Cassandra constituie o alegere de top printre lista de baze de date populare NoSQL, care este o bază de date gratuită și open-source, care este distribuită și are un depozit columnar larg și poate gestiona în mod eficient datele privind clusterele de mărfuri mari, adică este folosită asigura disponibilitate ridicata impreuna cu niciun punct de esec. Printre principalele caracteristici se numără cele precum natura distribuită, scalabilitatea, mecanismul tolerant la erori, suportul MapReduce, consistența reglabilă, proprietatea limbajului de interogare, acceptă replicarea mai multor centre de date și coerența eventuală.

În continuare ne permite să vorbim despre diferitele domenii ale tehnologiei de date mari, adică Data Mining.

5. Presto : este un popular motor de interogare distribuit bazat pe open-source și bazat pe SQL, care este utilizat pentru a rula interogări interactive împotriva surselor de date de fiecare scară, iar dimensiunea variază de la Gigabytes la Petabytes. Cu ajutorul său, putem interoga date în Cassandra, Hive, magazine de date proprii și sisteme relaționale de stocare a bazelor de date. Acesta este un motor de interogare bazat pe java, care a fost dezvoltat de fundația Apache în anul 2013. Câteva seturi de companii care folosesc bine instrumentul Presto sunt Netflix, Airbnb, Checkr, Repro și facebook.

5. Presto : este un popular motor de interogare distribuit bazat pe open-source și bazat pe SQL, care este utilizat pentru a rula interogări interactive împotriva surselor de date de fiecare scară, iar dimensiunea variază de la Gigabytes la Petabytes. Cu ajutorul său, putem interoga date în Cassandra, Hive, magazine de date proprii și sisteme relaționale de stocare a bazelor de date. Acesta este un motor de interogare bazat pe java, care a fost dezvoltat de fundația Apache în anul 2013. Câteva seturi de companii care folosesc bine instrumentul Presto sunt Netflix, Airbnb, Checkr, Repro și facebook.

6. Căutare Elastică : Acesta este un instrument foarte important astăzi când vine vorba de căutare. Aceasta constituie o componentă esențială a stivei ELK, adică căutarea elastică, Logstash și Kibana. ElasticSearch este un motor de căutare bazat pe bibliotecă Lucene, care este similar cu Solr și este utilizat pentru a furniza un motor de căutare cu text complet distribuit, care este capabil de mai mulți chiriași. Are o listă de documente JSON fără schema și o interfață web HTTP. Este scris în limba JAVA și este dezvoltat de compania Elastic în compania 2012. Numele câtorva companii care folosesc elasticsearch sunt: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture etc.

6. Căutare Elastică : Acesta este un instrument foarte important astăzi când vine vorba de căutare. Aceasta constituie o componentă esențială a stivei ELK, adică căutarea elastică, Logstash și Kibana. ElasticSearch este un motor de căutare bazat pe bibliotecă Lucene, care este similar cu Solr și este utilizat pentru a furniza un motor de căutare cu text complet distribuit, care este capabil de mai mulți chiriași. Are o listă de documente JSON fără schema și o interfață web HTTP. Este scris în limba JAVA și este dezvoltat de compania Elastic în compania 2012. Numele câtorva companii care folosesc elasticsearch sunt: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture etc.

Acum să citim despre toate acele tehnologii de date mari care fac parte din analiza datelor:

7. Apache Kafka : cunoscut pentru publicația-abonare sau sub-pub, așa cum este cunoscut în mod popular, este un sistem de broker de mesagerie asincronă de mesagerie directă, care este utilizat pentru a ingera și a efectua procesarea datelor pe date de streaming în timp real. De asemenea, oferă o prevedere a perioadei de păstrare, iar datele pot fi canalizate cu ajutorul unui mecanism producător-consumator. Este una dintre cele mai populare platforme de streaming, care este foarte asemănătoare cu sistemul de mesagerie pentru întreprinderi sau cu o coadă de mesagerie. Kafka a lansat până în prezent multe îmbunătățiri, iar un tip major este cel al confluentului Kafka, care oferă un nivel suplimentar de proprietăți pentru Kafka, cum ar fi registrul Schema, Ktables, KSql, etc. A fost dezvoltat de comunitatea Software Apache în anul 2011 și este scris în Java. Companiile care folosesc această tehnologie includ Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

7. Apache Kafka : cunoscut pentru publicația-abonare sau sub-pub, așa cum este cunoscut în mod popular, este un sistem de broker de mesagerie asincronă de mesagerie directă, care este utilizat pentru a ingera și a efectua procesarea datelor pe date de streaming în timp real. De asemenea, oferă o prevedere a perioadei de păstrare, iar datele pot fi canalizate cu ajutorul unui mecanism producător-consumator. Este una dintre cele mai populare platforme de streaming, care este foarte asemănătoare cu sistemul de mesagerie pentru întreprinderi sau cu o coadă de mesagerie. Kafka a lansat până în prezent multe îmbunătățiri, iar un tip major este cel al confluentului Kafka, care oferă un nivel suplimentar de proprietăți pentru Kafka, cum ar fi registrul Schema, Ktables, KSql, etc. A fost dezvoltat de comunitatea Software Apache în anul 2011 și este scris în Java. Companiile care folosesc această tehnologie includ Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

8. Splunk : Splunk este utilizat pentru a capta, corela și indexa date de streaming în timp real dintr-un depozit de căutare, de unde poate genera rapoarte, grafice, tablouri de bord, alerte și vizualizări de date. Este, de asemenea, utilizat pentru securitate, conformitate și gestionarea aplicațiilor și, de asemenea, pentru analiza web, generând informații despre afaceri și analize de afaceri. A fost dezvoltat de Splunk în Python, XML, Ajax.

8. Splunk : Splunk este utilizat pentru a capta, corela și indexa date de streaming în timp real dintr-un depozit de căutare, de unde poate genera rapoarte, grafice, tablouri de bord, alerte și vizualizări de date. Este, de asemenea, utilizat pentru securitate, conformitate și gestionarea aplicațiilor și, de asemenea, pentru analiza web, generând informații despre afaceri și analize de afaceri. A fost dezvoltat de Splunk în Python, XML, Ajax.

9. Apache Spark : Acum vine cea mai critică și cea mai așteptată tehnologie din domeniul tehnologiilor Big Data, adică Apache Spark. Este posibil printre cele care au cea mai mare cerere astăzi și folosește Java, Scala sau Python pentru procesarea sa. Aceasta este utilizată pentru a prelucra și trata în timp real datele de streaming prin utilizarea Spark Streaming, care utilizează operații de lot și ferestre pentru a face acest lucru. Spark SQL este utilizat pentru a crea cadre de date, seturi de date pe partea de sus a RDD-urilor și, prin urmare, oferind o aromă bună a transformărilor și acțiunilor care formează o componentă integrantă a Apache Spark Core. Alte componente, cum ar fi Spark Mllib, R și graphX, sunt utile și în cazul analizei și efectuării învățării automate și a științei datelor. Tehnica de calcul în memorie este cea care o face diferită de alte instrumente și componente și acceptă o mare varietate de aplicații. A fost dezvoltat de fundația Software Apache în limbajul Java în primul rând.

9. Apache Spark : Acum vine cea mai critică și cea mai așteptată tehnologie din domeniul tehnologiilor Big Data, adică Apache Spark. Este posibil printre cele care au cea mai mare cerere astăzi și folosește Java, Scala sau Python pentru procesarea sa. Aceasta este utilizată pentru a prelucra și trata în timp real datele de streaming prin utilizarea Spark Streaming, care utilizează operații de lot și ferestre pentru a face acest lucru. Spark SQL este utilizat pentru a crea cadre de date, seturi de date pe partea de sus a RDD-urilor și, prin urmare, oferind o aromă bună a transformărilor și acțiunilor care formează o componentă integrantă a Apache Spark Core. Alte componente, cum ar fi Spark Mllib, R și graphX, sunt utile și în cazul analizei și efectuării învățării automate și a științei datelor. Tehnica de calcul în memorie este cea care o face diferită de alte instrumente și componente și acceptă o mare varietate de aplicații. A fost dezvoltat de fundația Software Apache în limbajul Java în primul rând.

10. Limbajul R : R este un limbaj de programare și un mediu software gratuit, care este utilizat pentru calculul statistic și, de asemenea, pentru grafică într-unul dintre cele mai importante limbi din R. Acesta este unul dintre cele mai populare limbaje dintre oamenii de știință, minerii de date și Practicanți de date pentru dezvoltarea de programe statistice și în special în analiza datelor.

10. Limbajul R : R este un limbaj de programare și un mediu software gratuit, care este utilizat pentru calculul statistic și, de asemenea, pentru grafică într-unul dintre cele mai importante limbi din R. Acesta este unul dintre cele mai populare limbaje dintre oamenii de știință, minerii de date și Practicanți de date pentru dezvoltarea de programe statistice și în special în analiza datelor.

Haideți să discutăm acum tehnologiile legate de vizualizarea datelor.

11. Tabelul: Este instrumentul de vizualizare a datelor cel mai rapid și puternic în creștere, care este utilizat în domeniul informațiilor de afaceri. Analiza datelor este o mașină foarte rapidă care este posibilă cu ajutorul tabelului și vizualizările sunt create sub formă de foi de lucru și tablouri de bord. Este dezvoltat de compania tableau în anul 2013 și este scris în Python, C ++, Java și C. Companiile care folosesc Tableau sunt: QlikQ, Oracle Hyperion, Cognos etc.

11. Tabelul: Este instrumentul de vizualizare a datelor cel mai rapid și puternic în creștere, care este utilizat în domeniul informațiilor de afaceri. Analiza datelor este o mașină foarte rapidă care este posibilă cu ajutorul tabelului și vizualizările sunt create sub formă de foi de lucru și tablouri de bord. Este dezvoltat de compania tableau în anul 2013 și este scris în Python, C ++, Java și C. Companiile care folosesc Tableau sunt: QlikQ, Oracle Hyperion, Cognos etc.

12. Plotly : Plotly este utilizat în principal pentru a face graficele și componentele asociate mai rapid și mai eficient. Are un set mai bogat de biblioteci și API-uri, cum ar fi MATLAB, Python, R, Arduino, Julia, etc. Acest lucru poate fi utilizat în mod interactiv în notebook-uri Jupyter și Pycharm și poate fi folosit pentru a crea grafice interactive. A fost dezvoltat pentru prima dată în 2012 și scris în javascript. Puține companii care folosesc Plotly sunt paladine, bitbank etc.

12. Plotly : Plotly este utilizat în principal pentru a face graficele și componentele asociate mai rapid și mai eficient. Are un set mai bogat de biblioteci și API-uri, cum ar fi MATLAB, Python, R, Arduino, Julia, etc. Acest lucru poate fi utilizat în mod interactiv în notebook-uri Jupyter și Pycharm și poate fi folosit pentru a crea grafice interactive. A fost dezvoltat pentru prima dată în 2012 și scris în javascript. Puține companii care folosesc Plotly sunt paladine, bitbank etc.

Concluzie

În acest post, am studiat cele mai mari tehnologii de date mari, care sunt în largă utilizare astăzi. Sper că v-a plăcut. Urmăriți-ne pentru mai multe postări ca acestea.

Articole recomandate

Acesta este un ghid pentru Big Data Technologies. Aici am discutat despre o introducere și tipuri de tehnologii Big Data. Puteți parcurge și alte articole sugerate pentru a afla mai multe -

- Ce este Splunk Tool?

- R vs Python

- Ce este Matlab?

- Ce este MongoDB?

- Pași de urmat în Testarea mainframe

- Tipuri de uniri în Spark SQL (Exemple)

- Aflați diferitele tipuri de instrumente Kafka