Introducere în Metodele Kernel în învățarea mașinii

Algoritmul folosit pentru analiza modelului este denumit metoda Kernel în învățarea mașinii. În general, analiza se face pentru a găsi relații în seturi de date. Aceste relații pot fi grupări, clasificare, componente principale, corelație, etc. Majoritatea acestor algoritmi care rezolvă aceste sarcini de analiză a modelului, au nevoie de date în reprezentant brut, pentru a fi transformate explicit într-o reprezentare vectorială a caracteristicilor. Această transformare se poate face printr-o hartă de caracteristici specificată de utilizator. Deci, se poate considera că numai kernel-ul specificat de utilizator este necesar prin metoda kernel.

Terminologia Metoda Kernal provine de la faptul că folosesc funcția de kernel, ceea ce le permite să efectueze operațiunea în spațiu de înaltă dimensiune, implicit, fără a fi necesară calcularea coordonatelor datelor din spațiul respectiv. În schimb, pur și simplu calculează produsul interior între imaginile tuturor perechilor de date din spațiul caracteristicilor.

Aceste tipuri de operațiuni sunt din punct de vedere ieftin, de cele mai multe ori, în comparație cu calculul explicit al coordonatelor. Această tehnică este denumită „truc de sâmbure”. Orice model liniar poate fi convertit într-un model non-liniar prin aplicarea trucului de nucleu pe model.

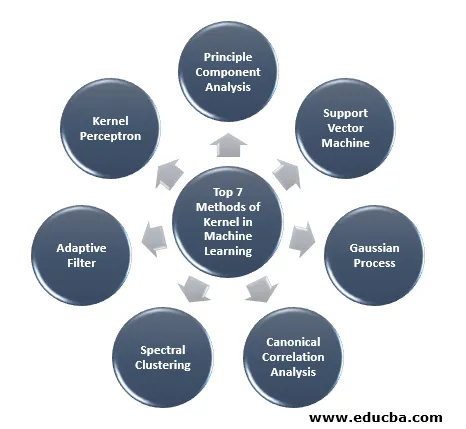

Metoda Kernel disponibilă în învățarea mașinilor este analiza componentelor principale (PCA), agregarea spectrală, mașinile de susținere a vectorului (SVM), analiza corelației canonice, perceptronul de kernel, procesele gaussiene, regresia creastă, filtrele adaptive liniare și multe altele. Haideți să înțelegem la nivel înalt câteva dintre aceste metode de kernel.

Top 7 metode ale nucleului în învățarea mașinii

Iată Metodele Kernelului în Mențiunea de învățare automată mai jos:

1. Analiza principiilor componente

Analiza componentelor principale (PCA) este o tehnică pentru extragerea structurii din seturi de date, probabil, de înaltă dimensiune. Se realizează cu ușurință folosind algoritmi iterativi care estimează componentele principale sau prin rezolvarea unei probleme de valorificare a valorii proprii. PCA este o transformare ortogonală a sistemului de coordonate în care descriem datele noastre. Noul sistem de coordonate este obținut prin proiecție pe principalele axe ale datelor. Un număr mic de componente principale este adesea suficient pentru a ține cont de cea mai mare parte a structurii din date. Una dintre aplicațiile sale majore este realizarea unei analize a datelor exploratorii pentru realizarea unui model predictiv. Acesta a folosit mai ales pentru a vizualiza relația dintre populații și distanța genetică.

2. Suport Vector Machine

SVM poate fi definit ca un clasificator pentru separarea hiperplanului unde hiperplanul este subspațiul cu o dimensiune mai mică decât spațiul ambiental. Dimensiunea acestui spațiu matematic este definită ca numărul minim de coordonate necesare pentru a specifica orice punct, în timp ce spațiul ambiental este spațiul care înconjoară obiectul matematic. Acum obiectul matematic poate fi înțeles ca un obiect abstract care nu există în niciun moment sau loc, dar există ca un tip de lucru.

3. Procesul Gaussian

Procesul gaussian a fost numit după Cark Friedrich Gauss, deoarece folosește notația distribuției gaussiene (distribuție normală). Este un proces stocastic care înseamnă o colecție de variabile aleatoare indexate în timp sau spațiu. În Procesul Gaussian variabilele aleatorii au o distribuție normală multivariată, adică toate combinațiile liniare finite ale acestuia sunt distribuite în mod normal. Procesul Gaussian folosește proprietățile moștenite de la o distribuție normală și, prin urmare, sunt utile în modelarea statistică. Algoritmul Machine Learning care implică această metodă de kernel folosește măsura învățării leneșe și asemănarea dintre puncte pentru a prezice valoarea punctelor nevăzute din datele de instruire. Această predicție nu este doar estimarea, ci incertitudinea în acel moment.

4. Analiza corelației canonice

Analiza de corelație canonică este o modalitate de a deduce informațiile din matricile de covarianță încrucișată. De asemenea, este cunoscută sub denumirea de analiză variatică canonică. Să presupunem că avem două vector X, Y de variabilă aleatorie spun doi vectori X = (X1, …, Xn) și vectorul Y = (Y1, …, Ym), iar variabila având corelație, atunci CCA va calcula o combinație liniară de X și Y care are corelația maximă între ele.

5. Clustering spectral

În aplicarea segmentării imaginilor, gruparea spectrală este cunoscută sub numele de categorizare a obiectelor bazată pe segmentare. În Spectral Clustering, reducerea dimensionalității se realizează înainte de clustering în dimensiuni mai puține, acest lucru se realizează prin utilizarea valorii proprii a matricei de similaritate a datelor. Își are rădăcinile în teoria graficului, unde această abordare este folosită pentru a identifica comunitățile de noduri într-un grafic care se bazează pe marginile care le leagă. Această metodă este suficient de flexibilă și ne permite să aglomerăm date și din grafice.

6. Filtru adaptiv

Filtrul adaptiv utilizează un filtru liniar care cuprinde o funcție de transfer, care este controlată de parametrii variabili și de metode, care va fi utilizat pentru a regla acești parametri conform algoritmului de optimizare. Complexitatea acestui algoritm de optimizare este motivul pentru care tot filtrul adaptiv este un filtru digital. Este necesar un filtru adaptiv în acele aplicații în care nu există informații prealabile cu privire la operațiunea de procesare dorită în prealabil sau se schimbă.

Funcția de cost este utilizată în filtrul cu buclă închisă, deoarece este necesară pentru performanța optimă a filtrului. Determină modul de modificare a funcției de transfer de filtru pentru a reduce costul următoarei iterații. Una dintre cele mai frecvente funcții este eroarea medie pătrată a semnalului de eroare.

7. Perceptron de sâmbure

În învățarea automată, perceptronul de kernel este un tip al popularului algoritm de învățare a perceptronului care poate învăța mașini de kernel, cum ar fi clasificatorii neliniari care utilizează o funcție de kernel pentru a calcula similaritatea acelor probe care nu sunt văzute cu probele de instruire. Acest algoritm a fost inventat în 1964, devenind astfel primul cursant de clasificare a kernel-ului.

Majoritatea algoritmilor de nucleu discutați se bazează pe optimizarea convexă sau pe eigenprobleme și sunt bine fundamentate statistic. Proprietățile lor statistice sunt analizate folosind teoria învățării statistice.

Vorbind despre zonele de aplicare a metodelor de sâmbure, este diversă și include geostatistică, kriging, ponderare la distanță inversă, reconstrucție 3D, bioinformatică, chimioinformatică, extragerea informațiilor și recunoașterea scrisului de mână.

Concluzie

Am rezumat câteva dintre terminologiile și tipurile de metode de kernel din Machine Learning. Din cauza lipsei de spațiu, acest articol, în niciun caz, este cuprinzător și este menit doar să vă ofere o înțelegere a metodei de sâmbure și a unui scurt rezumat al tipurilor lor. Cu toate acestea, acoperirea acestui articol vă va face să faceți primul pas în domeniul Învățării mașinilor.

Articole recomandate

Acesta este un ghid pentru Metoda Kernel în învățarea mașinii. Aici discutăm cele 7 tipuri de metode ale kernelului în învățarea mașinii. De asemenea, vă puteți uita la articolul următor.

- Nucleu monolitic

- Gruparea în învățarea mașinilor

- Învățarea mașinilor de știință a datelor

- Învățarea mașinii nesupravegheate

- Filtre PHP | Cum se validează introducerea utilizatorului folosind diverse filtre?

- Ghid complet pentru ciclul de viață al învățării mașinilor