Introducere în prelucrarea datelor în învățarea mașinii

Preprocesarea datelor în învățarea automată este o modalitate de a converti datele din formularul brut într-o formă mult mai formatată, inutilizabilă sau dorită. Este o sarcină integrală a învățării automate care este efectuată de oamenii de știință de date. Deoarece datele colectate sunt într-un format brut, s-ar putea să nu fie posibilă formarea modelului folosind-o. Este important să prelucrați cu atenție aceste date brute pentru a face o interpretare corespunzătoare din ele și pentru a evita în cele din urmă orice rezultat negativ în predicție. Pe scurt, calitatea algoritmului nostru de învățare depinde foarte mult de tipul de set de date pe care l-am folosit pentru a alimenta modelul, astfel încât pre-procesarea datelor să fie utilizată pentru a menține această calitate.

Datele colectate pentru instruirea modelului provin din diverse surse. Aceste date colectate sunt, în general, în formatul brut, adică pot avea zgomote precum valori lipsă și informații relevante, numere în formatul șirului etc. sau pot fi nestructurate. Pre-procesarea datelor crește eficiența și precizia modelelor de învățare a mașinilor. Întrucât ajută la înlăturarea acestor zgomote din și setul de date și da un sens setului de date

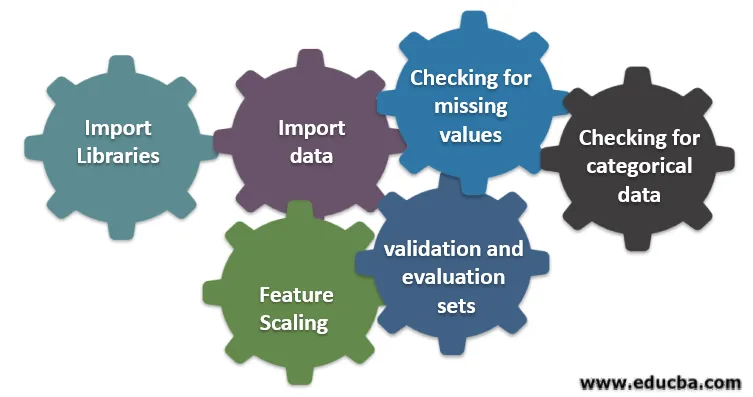

Șase etape diferite implicate în învățarea mașinii

Urmează șase etape diferite implicate în învățarea mașinii pentru a efectua pre-procesarea datelor:

Pasul 1: Importați bibliotecile

Pasul 2: importați date

Pasul 3: Verificarea valorilor lipsă

Pasul 4: Verificarea datelor categorice

Pasul 5: Scalarea caracteristicilor

Pasul 6: Împărțirea datelor în seturi de instruire, validare și evaluare

Să înțelegem fiecare dintre acești pași în detalii:

1. Importați bibliotecile

Primul pas este importarea câtorva dintre bibliotecile importante necesare în pre-procesarea datelor. O bibliotecă este o colecție de module care pot fi apelate și utilizate. În python, avem o mulțime de biblioteci care sunt utile în pre-procesarea datelor.

Câteva dintre următoarele biblioteci importante din python sunt:

- Numpy: utilizat în principal biblioteca pentru implementarea sau utilizarea calculelor matematice complicate ale învățării automate. Este util în efectuarea unei operații pe tablouri multidimensionale.

- Pandas : este o bibliotecă open source care oferă structură de date și instrumente de analiză a datelor de înaltă performanță și ușor de utilizat în python. Este conceput într-un mod pentru a facilita și intuitiv lucrul cu relațiile și datele etichetate.

- Matplotlib: Este o bibliotecă de vizualizare furnizată de python pentru parcele 2D o matrice. Este construit pe un tablou numpy și proiectat să funcționeze cu o stivă Scipy mai largă. Vizualizarea seturilor de date este utilă în scenariul în care sunt disponibile date mari. Ploturile disponibile în matplot lib sunt linie, bară, scatter, histogramă etc.

- Seaborn: Este, de asemenea, o bibliotecă de vizualizare dată de python. Oferă o interfață la nivel înalt pentru a crea grafice statistice atractive și informative.

2. Import de date

Odată importate bibliotecile, următorul nostru pas este încărcarea datelor colectate. Biblioteca Pandas este utilizată pentru a importa aceste seturi de date. Cele mai multe seturi de date sunt disponibile în format CSV, deoarece au dimensiuni reduse, ceea ce îl face rapid pentru procesare. Deci, pentru a încărca un fișier csv folosind funcția read_csv din biblioteca panda. Sunt diverse alte formate ale setului de date care pot fi văzute

Odată încărcat setul de date, trebuie să îl inspectăm și să căutăm orice zgomot. Pentru a face acest lucru, trebuie să creăm o matrice de caracteristici X și un vector de observație Y cu privire la X.

3. Verificarea valorilor lipsă

Odată ce ați creat matricea de caracteristici, puteți găsi că există unele valori care lipsesc. Dacă nu ne descurcăm, atunci poate să apară o problemă în momentul antrenamentului.

Există două metode de manipulare a valorilor lipsă:

- Îndepărtarea întregului rând care conține valoarea care lipsește, dar poate exista posibilitatea ca prin final să pierzi unele informații vitale. Aceasta poate fi o abordare bună dacă dimensiunea setului de date este mare.

- Dacă o coloană numerică are o valoare lipsă, atunci puteți estima valoarea luând media, mediana, modul etc.

4. Verificarea datelor categorice

Datele din setul de date trebuie să fie într-o formă numerică, astfel încât să poată fi efectuate calcule. Deoarece modelele de învățare automată conțin calcule matematice complexe, nu le putem alimenta o valoare non-numerică. Deci, este important să convertim toate valorile textului în valori numerice. Clasa LabelEncoder () învățată este folosită pentru a ascunde aceste valori categorice în valori numerice.

5. Scalarea caracteristicilor

Valorile datelor brute variază extrem de mult și poate duce la o formare părtinitoare a modelului sau poate ajunge la creșterea costului de calcul. Deci este important să le normalizăm. Scalarea caracteristicilor este o tehnică folosită pentru a aduce valoarea datelor într-un interval mai scurt.

Metodele utilizate pentru scalarea caracteristicilor sunt:

- Redimensionare (normalizare min-max)

- Normalizarea medie

- Standardizare (Z normalizare scor)

- Scalare la lungimea unității

6. Împărțirea datelor în seturi de instruire, validare și evaluare

În cele din urmă, trebuie să împărțim datele noastre în trei seturi diferite, set de instruire pentru a antrena modelul, set de validare pentru a valida acuratețea modelului nostru și în final set de testare pentru a testa performanța modelului nostru pe date generice. Înainte de a împărți setul de date, este important să schimbați setul de date pentru a evita existența unei prejudecăți. O proporție ideală pentru divizarea setului de date este 60:20:20 adică 60% ca set de antrenament, 20% ca set de validare și test. Pentru a împărți setul de date, folosiți train_test_split de sklearn.model_selection de două ori. Odată împărțit setul de date în set de validare tren și apoi să împărțiți setul de date al trenului rămas în set și test.

Concluzie - Preprocesarea datelor în învățarea mașinii

Preprocesarea datelor este ceva care necesită practică. Nu este ca o simplă structură de date în care înveți și aplici direct pentru a rezolva o problemă. Pentru a obține cunoștințe bune despre curățarea unui set de date sau despre modul de vizualizare a setului de date, trebuie să lucrați cu diferite seturi de date.

Cu cât veți folosi aceste tehnici, cu atât veți înțelege mai bine despre aceasta. Aceasta a fost o idee generală a modului în care procesarea datelor joacă un rol important în învățarea mașinii. Odată cu aceasta, am văzut, de asemenea, pașii necesari pentru pre-procesarea datelor. Așa că data viitoare înainte de a merge la formarea modelului folosind datele colectate, asigurați-vă că aplicați pre-procesarea datelor.

Articole recomandate

Acesta este un ghid pentru Preprocesarea datelor în învățarea mașinilor. Aici vom discuta introducerea, Șase etape diferite implicate în învățarea mașinii. Puteți parcurge și alte articole sugerate pentru a afla mai multe -

- Importanța inteligenței artificiale

- IoT Technology

- Tipuri de date PL / SQL

- Tipuri de stup stup

- R Tipuri de date