Introducere în arhitectura Big Data

Când vine vorba de gestionarea datelor grele și de a efectua operațiuni complexe pe acea masivă de date, este necesar să folosiți instrumente și tehnici de date mari. Când spunem că folosim instrumente și tehnici de date mari, înseamnă în mod eficient că cerem să utilizăm diverse programe software și proceduri care se află în ecosistemul de date mari și în sfera sa. Nu există o soluție generică care să fie furnizată pentru fiecare caz de utilizare și, prin urmare, trebuie să fie realizată și realizată într-un mod eficient, conform cerințelor de afaceri ale unei anumite companii. Astfel, devine necesară utilizarea diferitelor arhitecturi de date mari, deoarece combinarea diferitelor tehnologii va duce la realizarea cazului de utilizare rezultat. Prin stabilirea unei arhitecturi fixe se poate asigura că va fi furnizată o soluție viabilă pentru cazul de utilizare solicitat.

Ce este arhitectura Big Data?

- Această arhitectură este concepută astfel încât să se ocupe de procesul de ingerare, prelucrarea datelor și analiza datelor se face, care este prea mare sau complexă pentru a gestiona sistemele tradiționale de gestionare a bazelor de date.

- Diferitele organizații au praguri diferite pentru organizațiile lor, unele le au pentru câteva sute de gigabytes, în timp ce pentru altele, chiar și unele terabyte nu sunt suficient de bune pentru o valoare de prag.

- Datorită faptului că acest eveniment se întâmplă dacă vă uitați la sistemele de marfă și la stocarea mărfii, valorile și costul de stocare s-au redus semnificativ. Există o mare varietate de date care necesită diferite modalități de a fi furnizate.

- Unele dintre ele sunt date referitoare la loturi care vin la un moment dat și, prin urmare, lucrările trebuie să fie programate în mod similar, în timp ce altele aparțin clasei de streaming în care trebuie construită o conductă de streaming în timp real pentru a răspunde tuturor cerințe. Toate aceste provocări sunt rezolvate prin arhitectura de date mari.

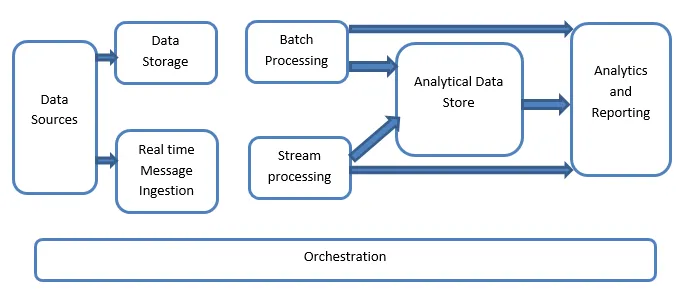

Explicația arhitecturii Big Data:

Sistemele Big Data implică mai multe tipuri de sarcină de muncă și sunt clasificate în linii următoare:

- În cazul în care sursele mari bazate pe date sunt în repaus, este implicată procesarea lotului.

- Prelucrare de date mari în mișcare pentru procesare în timp real.

- Explorarea instrumentelor și tehnologiilor interactive de date mari.

- Învățare automată și analiză predictivă.

1. Surse de date

Sursele de date implică toate acele surse de aur de unde este construită conducta de extracție a datelor și, prin urmare, se poate spune că acesta este punctul de pornire al conductei de date mari.

Exemplele includ:

(i) baze de date ale aplicațiilor, cum ar fi bazele de date relaționale

(ii) Fișierele produse de o serie de aplicații și sunt în mare parte o parte a sistemelor de fișiere statice, cum ar fi fișierele serverului bazate pe web care generează jurnalele.

(iii) dispozitive IoT și alte surse de date bazate în timp real.

2. Stocarea datelor

Aceasta include datele care sunt gestionate pentru operațiunile construite pe loturi și sunt stocate în depozitele de fișiere care sunt distribuite în natură și sunt, de asemenea, capabile să conțină volume mari de fișiere mari cu suport diferit de format. Se numește lac de date. Acest lucru constituie, în general, partea în care stocarea noastră Hadoop, cum ar fi depozitele HDFS, Microsoft Azure, AWS, GCP sunt furnizate împreună cu containerele blob.

3. Prelucrarea lotului

Toate datele sunt segregate în diferite categorii sau bucăți, ceea ce face uz de lucrări de lungă durată folosite pentru filtrarea și agregarea și, de asemenea, pregătirea datelor o stare procesată pentru analiză. Aceste joburi folosesc, de obicei, surse, le procesează și asigură ieșirea fișierelor procesate noilor fișiere. Prelucrarea lotului se face în diverse moduri, utilizând joburi Hive sau joburi bazate pe U-SQL sau folosind Sqoop sau Pig împreună cu lucrările reductorului de hartă personalizate, care sunt, în general, scrise în oricare dintre Java sau Scala sau oricare alt limbă precum Python.

4. Ingestie bazată pe mesaje în timp real

Aceasta include, spre deosebire de procesarea lotului, toate acele sisteme de transmisie în timp real care se ocupă de datele generate în mod secvențial și într-un model fix. Acesta este adesea un simplu mart martor sau un magazin responsabil pentru toate mesajele primite care sunt introduse în folderul folosit în mod necesar pentru procesarea datelor. Cu toate acestea, există o majoritate de soluții care necesită necesitatea unui depozit de ingestie bazat pe mesaje, care să funcționeze ca un tampon de mesaje și, de asemenea, să susțină procesarea bazată pe scară, asigură o livrare relativ fiabilă, împreună cu alte semantice în coada de mesagerie. Opțiunile includ cele precum Apache Kafka, Apache Flume, hub-uri de evenimente de la Azure etc.

5. Procesarea fluxului

Există o ușoară diferență între ingerarea mesajelor în timp real și procesarea fluxului. Primul ia în considerare datele ingerate care sunt colectate la început și apoi sunt utilizate ca un tip de abonament pentru publicare. Procesarea fluxului, pe de altă parte, este utilizată pentru a gestiona toate acele date de flux care apar în ferestre sau fluxuri și apoi scrie datele în chiuveta de ieșire. Aceasta include Apache Spark, Apache Flink, Storm etc.

6. Datastore bazat pe Analytics

Acesta este depozitul de date care este utilizat în scopuri analitice și, prin urmare, datele deja procesate sunt apoi interogate și analizate folosind instrumente de analiză care pot corespunde soluțiilor BI. Datele pot fi, de asemenea, prezentate cu ajutorul unei tehnologii de stocare a datelor NoSQL, precum HBase sau orice utilizare interactivă a bazei de date stup, care poate asigura extragerea metadatelor în depozitul de date. Instrumentele includ Hive, Spark SQL, Hbase etc.

7. Raportare și analiză

Informațiile trebuie să fie generate pe datele procesate și acest lucru este realizat în mod eficient de instrumentele de raportare și analiză, care utilizează tehnologia și soluția lor încorporate pentru a genera grafice, analize și informații utile pentru companii. Instrumentele includ Cognos, Hyperion etc.

8. Orchestrare

Soluțiile bazate pe date constau în operații legate de date care sunt de natură repetitivă și sunt, de asemenea, încapsulate în fluxurile de lucru, care pot transforma datele sursă și, de asemenea, muta datele peste surse, precum și chiuvete și încărcare în magazine și împinge în unități analitice. Exemple includ Sqoop, oozie, fabrica de date etc.

Concluzie

În acest post, citim despre arhitectura de date mari care este necesară pentru implementarea acestor tehnologii în companie sau organizație. Sper că v-a plăcut articolul nostru.

Articole recomandate

Acesta a fost un ghid pentru arhitectura Big Data. Aici discutăm despre ce este datele mari? și, de asemenea, am explicat arhitectura de date mari împreună cu diagrama bloc. Puteți parcurge și alte articole sugerate pentru a afla mai multe -

- Tehnologii de date mari

- Analiza Big Data

- Cariere în Big Data

- Întrebări la interviu Big Data

- Top 8 dispozitive ale IoT pe care ar trebui să le știi

- Tipuri de uniri în Spark SQL (Exemple)