Introducere în algoritmii de știință a datelor

O descriere la nivel înalt a algoritmilor esențiali folosiți în Data Science. După cum știți deja, știința datelor este un domeniu de studiu în care deciziile sunt luate pe baza informațiilor pe care le obținem din date în loc de abordările deterministice clasice bazate pe reguli. De obicei, putem împărți o sarcină de învățare a mașinilor în trei părți

- Obținerea datelor și maparea problemei de afaceri,

- Aplicarea tehnicilor de învățare automată și respectarea metricii de performanță

- Testarea și implementarea modelului

În tot acest ciclu de viață, utilizăm diferiți algoritmi de știință a datelor pentru a rezolva sarcina la îndemână. În acest articol, vom împărți algoritmii cei mai folosiți în funcție de tipurile lor de învățare și vom avea o discuție la nivel înalt despre aceștia.

Tipuri de algoritmi de știință a datelor

Pe baza metodologiilor de învățare, putem împărți pur și simplu algoritmii de învățare automată sau de știință a datelor în următoarele tipuri

- Algoritmi supravegheați

- Algoritmi nesupravegheați

1. Algoritmi supravegheați

După cum sugerează numele algoritmii supravegheți sunt o clasă de algoritmi de învățare automată în care modelul este instruit cu datele etichetate. De exemplu, pe baza datelor istorice, doriți să prezicem că un client va imprumuta sau nu un împrumut. După preprocesarea și ingineria caracteristicilor datelor etichetate, algoritmii supravegheți sunt instruiți asupra datelor structurate și testate pe un punct de date nou sau, în acest caz, pentru a prezice un imprumut de imprumut. Haideți să ne cufundăm în cei mai populari algoritmi de învățare automată supravegheată.

- K Vecini cei mai apropiați

K vecinii cei mai apropiați (KNN) sunt unul dintre cei mai simpli algoritmi de învățare automată. Este un algoritm supravegheat în care clasificarea se face pe baza celor mai apropiate k puncte de date. Ideea din spatele KNN este că puncte similare sunt grupate împreună, prin măsurarea proprietăților punctelor de date cele mai apropiate putem clasifica un punct de date de testare. De exemplu, rezolvăm o problemă de clasificare standard în care dorim să prezicem că un punct de date aparține clasei A sau clasei B.Let k = 3, acum vom testa 3 cea mai apropiată informație de date a punctului de testare, dacă două dintre ele aparțin clasei A vom declara punctul de testare ca fiind clasa A în caz contrar clasa B. Valoarea corectă a lui K se găsește prin validare încrucișată. Are o complexitate de timp liniară, deci nu poate fi utilizat pentru aplicații cu latență scăzută.

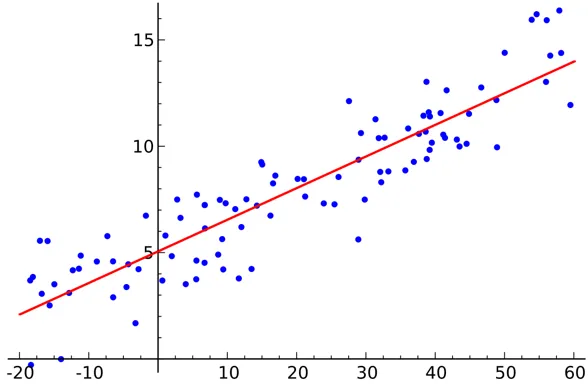

- Regresie liniara

Regresia liniară este un algoritm de știință a datelor supravegheat.

ieşire:

Variabila este continuă. Ideea este de a găsi un hiperplan în care numărul maxim de puncte se află în hiperplan. De exemplu, prezicerea cantității de ploaie este o problemă de regresie standard în care poate fi utilizată regresia liniară. Regresia liniară presupune că relația dintre variabilele independente și dependente este liniară și există o multicolinearitate foarte mică sau deloc.

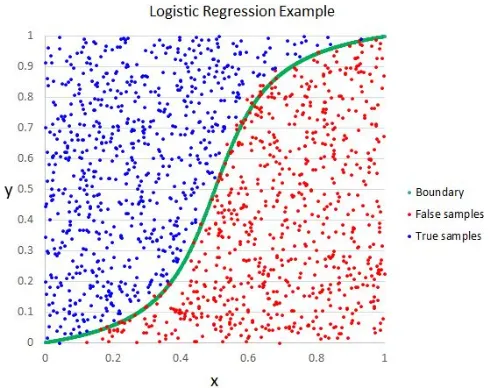

- Regresie logistică

Deși numele spune regresie, regresia logistică este un algoritm de clasificare supravegheat.

ieşire:

Intuiția geometrică este că putem separa diferite etichete de clasă folosind o graniță liniară de decizie. Variabila de ieșire a regresiei logistice este categorică. Vă rugăm să rețineți că nu putem folosi eroarea medie pătrată ca funcție de cost pentru regresia logistică, deoarece este neconvexă pentru regresia logistică.

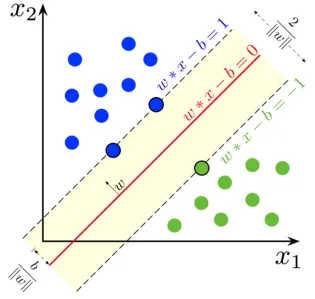

- Suport Vector Machine

În regresia logistică, deviza noastră principală era să găsim o suprafață liniară care separă.

ieşire:

Putem considera mașina vectorului de asistență ca o extensie a acestei idei unde trebuie să găsim un hiperplan care să maximizeze marja. Dar ce este o marjă ?. Pentru un vector W (suprafața de decizie cu care trebuie să venim), desenăm două linii paralele pe ambele părți. Distanța dintre aceste două linii se numește marjă. SVM presupune că datele sunt separabile liniar. Deși putem folosi SVM pentru date neliniare folosind și trucul Kernel.

- Arborele de decizii

Tree Tree este un clasificator bazat pe If-Else, care folosește o structură grafică asemănătoare arborelui pentru a lua decizia. Arborii de decizie sunt foarte populari și unul dintre cei mai folosiți algoritmi de învățare automată supravegheată din toată domeniul științei datelor. Oferă o stabilitate și o precizie mai bune în majoritatea cazurilor comparativ cu alți algoritmi supravegheți și robuste pentru valorile superioare. Variabila de ieșire a arborelui decizional este de obicei categorică, dar poate fi folosită și pentru rezolvarea problemelor de regresie.

- ansambluri

Ansamblurile sunt o categorie populară de algoritmi de știință a datelor unde mai multe modele sunt utilizate împreună pentru a obține performanțe mai bune. Dacă sunteți familiarizat cu Kaggle (o platformă de Google pentru a exersa și a concura în provocările științei datelor), veți găsi cele mai multe soluții câștigătoare care folosesc un fel de ansamblu.

Putem împărți aproximativ ansamblurile în următoarele categorii

- Bagging

- stimularea

- stivuirea

- Cascading

Pădure aleatoare, arbori decizionali de stimulare a gradientului sunt exemple ale unor algoritmi populari de ansamblu.

2. Algoritmi nesupravegheați

Algoritmii nesupravegheați sunt folosiți pentru sarcinile în care datele nu sunt etichetate. Cel mai popular caz de utilizare al algoritmilor nesupervizați este clusteringul. Gruparea este sarcina de a grupa puncte de date similare fără intervenție manuală. Hai să discutăm unele dintre cele mai populare algoritmi de învățare a mașinilor nesupervizate aici

- K înseamnă

K Means este un algoritm randomizat nesupravegheat folosit pentru clustering. K Means urmează pașii de mai jos

1. Inițializează punctele K la întâmplare (c1, c2..ck)

2. Pentru fiecare punct (Xi) din setul de date

Selectați cel mai apropiat Ci (i = 1, 2, 3..k)

Adăugați Xi în Ci

3. Recomputați centroidul folosind metrici adecvați (adică distanță intraclusivă)

4, Repetați pasul (2) (3) până când converg

- K înseamnă ++

Etapa de inițializare în mijloace K este pur aleatorie și se bazează pe inițializare, gruparea se schimbă drastic. K înseamnă ++ rezolvă această problemă prin inițializarea k într-un mod probabilistic în loc de randomizarea pură. K înseamnă ++ este mai stabil decât înseamnă K clasic.

- K Medoids:

K medoids este, de asemenea, un algoritm de clustering bazat pe mijloace K. Principala diferență între cei doi este că centroidele K înseamnă că nu există neapărat în setul de date, ceea ce nu este cazul medoidelor K. Medoidele K oferă o mai bună interpretabilitate a clusterelor. K înseamnă minimizarea erorii pătrate totale în timp ce K medoids minimizează disimilitatea dintre puncte.

Concluzie

În acest articol, am discutat despre cei mai populari algoritmi de învățare a mașinilor utilizate în domeniul științei datelor. După toate acestea, o întrebare poate să-ți vină în minte că „ Ce algoritm este cel mai bun? „ În mod clar, nu există niciun câștigător aici. Depinde exclusiv de sarcina la îndemână și de cerințele de afaceri. Ca o bună practică începe întotdeauna cu cel mai simplu algoritm și crește complexitatea treptat.

Articole recomandate

Acesta a fost un ghid pentru algoritmii de știință a datelor. Aici am discutat o imagine de ansamblu asupra algoritmilor de știință a datelor și două tipuri de algoritmi de știință a datelor. De asemenea, puteți parcurge articolele noastre date pentru a afla mai multe-

- Platforma de știință a datelor

- Limbi de știință a datelor

- Algoritmi de clasificare

- Algoritmi de extragere a datelor

- Cele mai utilizate tehnici de învățare a ansamblurilor

- Modalități simple de a crea arborele de decizie

- Ghid complet al ciclului de știință a datelor